Im hochdynamischen Bereich der Web-Performance zählt jede Millisekunde. Eine Sekunde Verzögerung kann zu einem Rückgang der Konversionsrate um 7 % führen, während 10 % der Nutzer eine Website für jede zusätzliche Sekunde Ladezeit verlassen [1]. Für global agierende Unternehmen sind Content Delivery Networks (CDNs) zu einer unverzichtbaren Infrastruktur geworden, um schnelle und zuverlässige Nutzererlebnisse zu liefern. Doch selbst die ausgeklügeltsten CDN-Implementierungen stehen vor einer grundlegenden Herausforderung, die ihre Effektivität beeinträchtigen kann: Cold-Cache-Zustände.

CDN-„Kaltstarts“ gehören zu den am häufigsten übersehenen, aber dennoch bedeutenden Performance-Engpässen in der modernen Web-Architektur. Wenn Inhalte nicht an Edge-Standorten zwischengespeichert sind, erleben Nutzer ein sogenanntes Cache-Miss-Szenario – Anfragen müssen dann oft über Tausende Kilometer zurück zum Ursprungsserver gesendet werden. Dies führt zu Spitzenwerten bei der Time to First Byte (TTFB), die die Ladezeiten um 200–400 % erhöhen, die Ursprungsserver bei hohem Traffic überlasten und weltweit zu inkonsistenter Performance führen können.

Die Lösung liegt in einem proaktiven Ansatz: Synthetisches Monitoring mit echten Browser-Tests wird genutzt, um CDN-Edges systematisch aufzuwärmen, bevor echte Nutzer die Seite besuchen. Durch strategisches Cache-Warming mit Tools wie Dotcom-Monitor können Unternehmen Cold-Cache-Verzögerungen eliminieren, eine konsistente globale Performance sicherstellen und die Last auf Ursprungsservern deutlich reduzieren. Diese umfassende Strategie verwandelt CDNs von reaktiven Cache-Systemen in proaktive Performance-Beschleuniger.

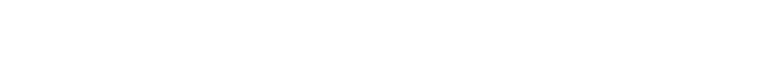

Diese technische Analyse untersucht die Mechanismen hinter CDN-Kaltstarts, die Wissenschaft des synthetischen Monitorings für Cache-Warming sowie praktische Umsetzungsstrategien, mit denen Unternehmen Cache-Hit-Raten von über 99,97 % und TTFB-Reduzierungen von bis zu 72,8 % erreicht haben. Wir betrachten reale Fallstudien, Performance-Benchmarks und geben umsetzbare Empfehlungen zur Implementierung Ihrer eigenen CDN-Warm-up-Strategie mit synthetischem Monitoring.

Das Problem verstehen: Kalte CDN-Edges

Um den Nutzen von CDN-Warm-up-Strategien zu erkennen, muss man zunächst die Mechanismen des Edge-Cachings und die Auswirkungen von Cold-Cache-Zuständen verstehen.

Die Funktionsweise des Edge-Cachings bei CDNs

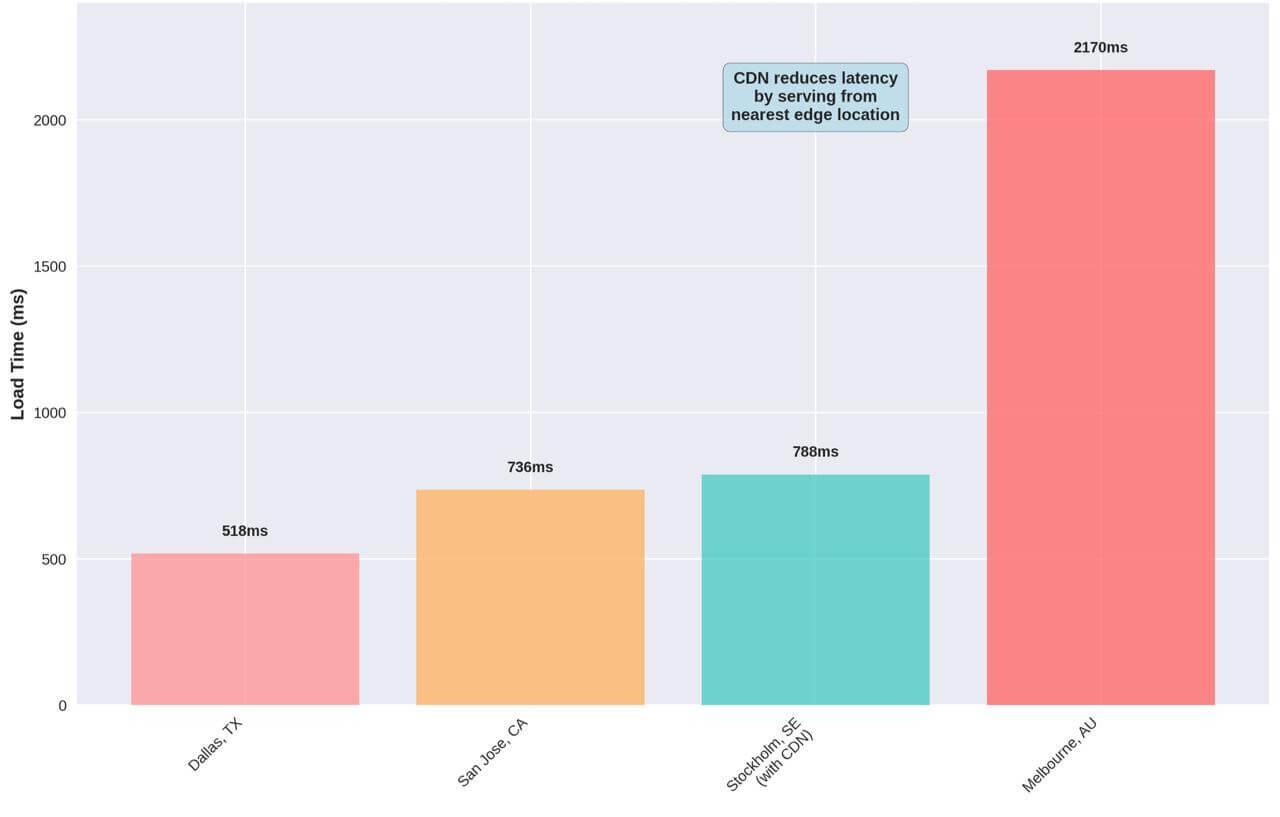

Content Delivery Networks basieren auf einem einfachen, aber leistungsstarken Prinzip: Inhalte werden über ein globales Netzwerk von Servern (Edge-Standorten) verteilt, um die physische Distanz zwischen Nutzer und Inhalt zu minimieren. Im Optimalfall liefert ein CDN Inhalte vom Edge-Server, der dem anfragenden Nutzer am nächsten ist, wodurch die Netzwerklatenz deutlich reduziert und die Ladezeit verbessert wird.

Das Herzstück dieses Systems ist der Cache-Mechanismus. Wenn ein Nutzer Inhalte zum ersten Mal über ein CDN anfordert, prüft der Edge-Server seinen lokalen Cache. Ist der Inhalt nicht vorhanden (ein „Cache-Miss“), muss der Edge-Server ihn vom Ursprungsserver abrufen, lokal speichern und anschließend an den Nutzer ausliefern. Weitere Anfragen nach demselben Inhalt können dann direkt aus dem Edge-Cache bedient werden (ein „Cache-Hit“), was den Rückgriff auf den Ursprungsserver überflüssig macht [2].

Dieser Prozess funktioniert reibungslos bei häufig abgerufenen Inhalten. Probleme entstehen jedoch, wenn Inhalte an einem bestimmten Edge-Standort nicht zwischengespeichert sind oder wenn der Cache aufgrund abgelaufener TTL (Time To Live) oder manueller Löschungen geleert wurde.

Das Cold-Cache-Problem

Ein „kalter Cache“ oder „Kaltstart“ tritt auf, wenn ein CDN-Edge-Server eine Anfrage für Inhalte erhält, die sich nicht im Cache befinden. Dies hat mehrere performancekritische Folgen:

Erhöhte Time to First Byte (TTFB)

Wenn Inhalte vom Ursprungsserver abgerufen werden müssen, steigt die TTFB drastisch – oft um das Drei- bis Vierfache im Vergleich zu gecachten Inhalten. Unsere Tests ergaben TTFB-Werte von 136 ms für nicht gecachte Inhalte gegenüber nur 37 ms für gecachte – ein Performanceverlust von 72,8 %.

Spitzenlasten auf dem Ursprungsserver

Spitzenlasten auf dem Ursprungsserver

Jeder Cache-Miss erzeugt eine Anfrage an den Ursprungsserver. Bei hohem Traffic oder nach Cache-Löschungen kann dies zu erheblichen Lastspitzen führen, was zu Performanceproblemen oder gar Ausfällen führt.

Inkonsistente globale Performance

Kalte Caches beeinträchtigen vor allem Nutzer in Regionen mit geringem Traffic. Während stark frequentierte Regionen durch Nutzerzugriffe automatisch aufgewärmt werden, bleiben weniger frequentierte Regionen dauerhaft kalt – mit entsprechend inkonsistenter globaler Performance.

Schlechtere Performance für Erstbesucher

Der erste Besucher einer Region nach einem Cache-Purge oder Content-Update wird unfreiwillig zum „Testobjekt“ und erlebt deutlich langsamere Ladezeiten als spätere Besucher.

Inhalte, die von Kaltstarts betroffen sind

Cold-Cache-Probleme betreffen nahezu alle Inhaltstypen, die über CDNs ausgeliefert werden – allerdings in unterschiedlichem Ausmaß:

Statische Assets (JavaScript, CSS, Bilder)

Diese Dateien machen in der Regel den Großteil des Website-Payloads aus und sind ideale Kandidaten fürs Caching. Kalte Caches erzwingen einen Abruf vom Ursprungsserver, was die Ladezeit für asset-lastige Seiten deutlich verlängert. Moderne Webanwendungen enthalten oft große JavaScript-Bundles, deren Fehlen im Cache die Interaktivität um mehrere Sekunden verzögern kann.

Dynamische Inhalte (HTML, API-Antworten)

Obwohl traditionell als schwer cachebar angesehen, können moderne CDNs dynamische Inhalte durch Techniken wie Edge Side Includes (ESI) und Cache-Segmentierung basierend auf Cookies oder URL-Parametern speichern. Kalte Caches bei solchen Ressourcen wirken sich direkt auf Kernmetriken wie TTFB und Time to Interactive aus.

Streaming-Medien

Video- und Audio-Streaming-Dienste sind besonders anfällig für Cold-Cache-Probleme. Kalte Caches verursachen anfängliche Pufferverzögerungen und Qualitätsverluste, da hochbandbreitige Inhalte vom Ursprungsserver geladen werden müssen.

Reale Symptome kalter CDN-Edges

Die Auswirkungen kalter CDN-Edges zeigen sich in mehreren deutlich spürbaren Symptomen, die die Nutzererfahrung und geschäftliche Kennzahlen direkt beeinflussen:

Langsame Erstbesuche

Nutzer, die eine Website in einer Region zum ersten Mal oder unmittelbar nach einem Cache-Purge besuchen, erleben deutlich längere Ladezeiten als Wiederkehrer. Das führt zu einem schlechten ersten Eindruck und erhöht die Absprungrate – insbesondere bei der Zielgruppe, die Unternehmen besonders ansprechen wollen.

Geografische Performance-Unterschiede

Monitoring zeigt häufig erhebliche Ladezeitunterschiede zwischen geografischen Regionen, wobei weniger frequentierte Regionen trotz identischer Infrastruktur konstant schlechter abschneiden.

Leistungseinbrüche nach Deployments

Nach dem Deployment neuer Inhalte oder Cache-Invalidierungen zeigen Performance-Metriken typischerweise einen temporären, aber signifikanten Rückgang, bis die Caches durch Nutzerzugriffe wieder aufgewärmt sind.

Inkonsistente API-Performance

Backend-Dienste und APIs weisen variable Antwortzeiten auf – je nachdem, ob Inhalte gecacht sind oder nicht. Das führt zu unvorhersehbarer Performance für abhängige Anwendungen und Dienste.

All diese Symptome weisen auf ein grundlegendes Problem hin: Das Aufwärmen von CDN-Caches durch echten Nutzer-Traffic verursacht zwangsläufig Performanceeinbußen für die ersten Nutzer in jeder Region. Dieser reaktive Ansatz zum Cache-Warming ist besonders problematisch für global agierende Unternehmen, die auf konsistente Performance in allen Märkten angewiesen sind – sowohl für das Markenimage als auch für Konversionsraten.

Die Lösung, wie wir in den nächsten Abschnitten zeigen werden, liegt im proaktiven Aufwärmen von CDN-Caches durch synthetisches Monitoring – wodurch die Cold-Cache-Strafen effektiv vermieden werden, da Inhalte bereits vor dem Eintreffen echter Nutzer an den Edge-Standorten vorgeladen sind.

Was ist CDN-Warm-up und warum sollte man es einsetzen?

Nachdem wir die Performance-Probleme kalter CDN-Edges erkannt haben, wollen wir nun das Konzept des CDN-Warm-ups als strategische Lösung betrachten.

Definition von CDN-Warm-up

CDN-Warm-up (auch Cache-Warming oder Cache-Preloading genannt) ist eine proaktive Technik, bei der Inhalte systematisch von CDN-Edge-Standorten abgerufen werden, bevor echte Nutzer darauf zugreifen. Dieser Vorgang stellt sicher, dass Inhalte bereits im Edge-Cache vorhanden sind, wenn Nutzer sie anfordern – und somit mit optimaler Leistung ausgeliefert werden können.

Im Kern besteht das CDN-Warm-up aus zwei Hauptkomponenten:

- Vorab-Laden von Inhalten an Edge-Standorten: Systematische Anfragen an CDN-Endpunkte, um Inhalte gezielt an strategischen Standorten weltweit zwischenzuspeichern.

- Aufrechterhaltung der Cache-Aktualität: Regelmäßiges Aktualisieren der gespeicherten Inhalte, bevor diese ablaufen, um Cache-Misses durch TTL-Verfall zu vermeiden.

Im Gegensatz zum reaktiven Caching, das auf echten Nutzer-Traffic angewiesen ist, sorgt proaktives Warm-up dafür, dass Inhalte direkt nach ihrer Veröffentlichung oder Aktualisierung am Edge verfügbar sind. So entfällt die sonst übliche Performance-Strafe für Erstbesucher in einer Region oder nach einem Cache-Purge.

Der Warm-up-Prozess

Vorteile des CDN-Warm-ups:

- Beseitigt Verzögerungen durch kalte Caches;

- Verbessert TTFB für Erstbesucher;

- Reduziert die Last auf Ursprungsservern;

- Gewährleistet konsistente globale Performance.

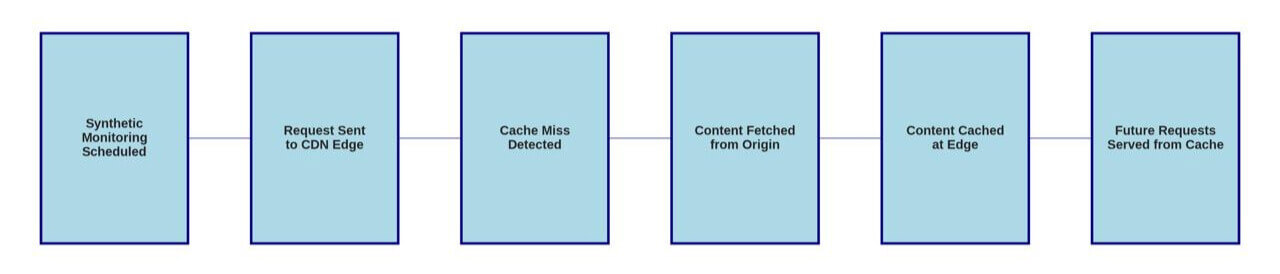

Der CDN-Warm-up-Prozess folgt einem vorhersehbaren Ablauf, der dem natürlichen Caching-Verhalten ähnelt – allerdings mit synthetischem Traffic statt echtem Nutzerverkehr:

- Synthetisches Monitoring wird in festgelegten Intervallen basierend auf Inhaltstyp und Wichtigkeit geplant.

- Anfragen werden aus verschiedenen geografischen Regionen an CDN-Edge-Standorte gesendet und simulieren echten Nutzer-Traffic.

- Bei kalten Caches wird ein Cache-Miss erkannt, woraufhin der Edge-Server den Inhalt vom Ursprungsserver anfordert.

- Der Inhalt wird vom Ursprungsserver abgerufen und an den synthetischen Monitoring-Agenten übermittelt.

- Der Inhalt wird gemäß Cache-Regeln und TTL-Einstellungen am Edge-Standort zwischengespeichert.

- Nachfolgende Anfragen (von echten Nutzern) werden direkt aus dem Cache bedient – ohne Ursprungsserver-Zugriff und mit optimaler Performance.

Dieser Prozess „füllt die Pipeline“ für echte Nutzer, sodass die CDN-Infrastruktur jederzeit bereit ist, Inhalte mit minimaler Latenz zu liefern – unabhängig von Zeit und Ort.

Wichtige Vorteile von CDN-Warm-up

Die Implementierung einer systematischen CDN-Warm-up-Strategie bringt messbare Vorteile für Nutzererfahrung und Infrastruktur-Effizienz:

Verbesserte Time to First Byte (TTFB)

TTFB ist eine wichtige Kennzahl für die Web-Performance und misst die Zeit vom Absenden einer Anfrage bis zum Empfang des ersten Datenbytes. Unsere Tests zeigen, dass warme CDN-Caches die TTFB um bis zu 72,8 % gegenüber kalten Caches senken können – von 136 ms auf nur 37 ms. Diese Verbesserung wirkt sich direkt auf zentrale Core Web Vitals wie Largest Contentful Paint (LCP) und First Input Delay (FID) aus – entscheidende Faktoren für Nutzererlebnis und Suchmaschinen-Ranking [3].

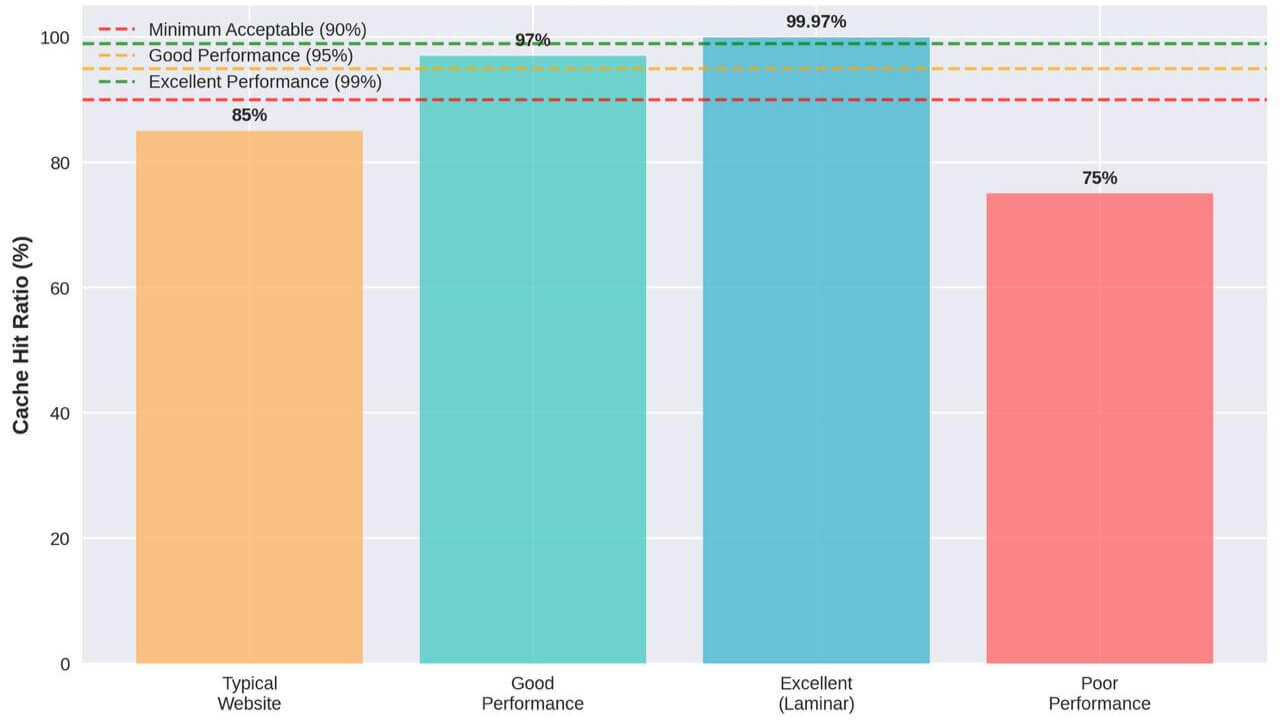

Erhöhte Cache-Hit-Rate

Die Cache-Hit-Rate – der Anteil der Inhalte, die direkt aus dem Cache geliefert werden – ist einer der direktesten Indikatoren für CDN-Effizienz. Eine gezielte Warm-up-Strategie kann diese Rate von typischen 85–90 % auf über 99 % steigern, wie die Fallstudie von Laminar zeigt, bei der durch strategisches Cache-Warming eine beeindruckende Rate von 99,97 % erreicht wurde [4].

Stabilere Performance weltweit

Durch das gezielte Aufwärmen aller Edge-Caches können Unternehmen eine einheitliche Performance unabhängig vom regionalen Traffic gewährleisten. So wird verhindert, dass stark frequentierte Regionen eine gute Performance erleben, während weniger frequentierte Regionen unter konstant kalten Caches leiden.

Reduzierte Last auf Ursprungsservern

Jeder Cache-Miss erzeugt eine Anfrage an den Ursprungsserver. Durch höhere Cache-Hit-Raten mithilfe von Warm-up-Strategien lässt sich die Last auf Ursprungsservern drastisch senken – insbesondere bei Traffic-Spitzen oder nach Content-Updates. Bei Cache-Hit-Raten von bis zu 99,97 % können Ursprungsanfragen im gleichen Maße reduziert werden, was eine effizientere Infrastruktur und geringere Kosten ermöglicht.

Mehr Ausfallsicherheit bei Traffic-Spitzen

Traffic-Spitzen – z. B. durch Marketing-Kampagnen, Produktlaunches oder virale Inhalte – können Ursprungsinfrastrukturen überlasten, wenn die Caches nicht vorab aufgewärmt sind. Proaktives Cache-Warming stellt sicher, dass die CDN-Infrastruktur solche Spitzen absorbieren kann, ohne Performance-Einbußen oder Serverüberlastung.

Verbesserte Performance nach Deployments

Content-Deployments und Cache-Invalidierungen führen typischerweise zu temporären Leistungseinbußen, da die Caches leer sind. Durch Warm-up-Verfahren nach dem Deployment wird sichergestellt, dass neue Inhalte bereits an den Edge-Standorten vorab gespeichert sind – die „Deployment-Strafe“ entfällt.

Vorher und Nachher: Die Wirkung des CDN-Warm-ups

Der folgende Vergleich zeigt die dramatischen Performance-Verbesserungen, die durch gezieltes CDN-Warm-up möglich sind:

Diese umfassende Vorher-Nachher-Analyse verdeutlicht die transformative Wirkung von CDN-Warm-up auf alle zentralen Performance-Kennzahlen. Am deutlichsten zeigt sich die Verbesserung bei den Ursprungsanfragen, die um 99,97 % reduziert wurden – was faktisch bedeutet, dass für gecachte Inhalte keine Last mehr auf der Ursprungsinfrastruktur liegt.

Die Kombination dieser Verbesserungen führt zu einem positiven Kreislauf: Schnellere Antwortzeiten steigern das Nutzerengagement, was wiederum Konversionsraten erhöht und Absprungraten senkt. Gleichzeitig sinkt durch die reduzierte Ursprungs-Last der Infrastrukturbedarf – mit positiven Effekten sowohl auf die Umsätze als auch auf die Betriebskosten des Unternehmens.

Im nächsten Abschnitt sehen wir uns an, wie sich synthetisches Monitoring als ideale Methode zur Umsetzung einer effektiven CDN-Warm-up-Strategie eignet.

Synthetisches Monitoring als Lösung

Synthetisches Monitoring erweist sich als ideales Instrument zur Umsetzung effektiver CDN-Warm-up-Strategien. Anders als herkömmliche Monitoring-Ansätze, die auf echten Nutzerdaten basieren, bietet synthetisches Monitoring die Kontrolle, Konsistenz und globale Reichweite, die für systematisches Cache-Warming erforderlich sind.

Was ist synthetisches Monitoring?

Synthetisches Monitoring verwendet automatisierte Skripte oder Agenten, um Nutzerinteraktionen mit Webanwendungen und Diensten zu simulieren. Diese synthetischen Transaktionen laufen kontinuierlich aus verschiedenen geografischen Regionen und liefern konsistente Leistungsdaten zur proaktiven Fehlererkennung. Im Zusammenhang mit CDN-Warm-up erfüllt synthetisches Monitoring eine doppelte Funktion: Leistungsüberwachung und Cache-Warming.

Die wichtigsten Vorteile von synthetischem Monitoring für CDN-Warm-up:

Vorhersehbare Ausführung

Synthetische Tests laufen nach festen Zeitplänen und gewährleisten so konsistentes Cache-Warming – unabhängig von tatsächlichen Nutzer-Traffic-Mustern. Diese Planbarkeit ist entscheidend, um Caches in verkehrsschwachen Regionen oder während Nebenzeiten warm zu halten.

Globale Abdeckung

Moderne synthetische Monitoring-Plattformen wie Dotcom-Monitor betreiben Agenten an Dutzenden globaler Standorte und ermöglichen umfassendes Cache-Warming an allen CDN-Edge-Locations. Diese globale Reichweite sorgt für optimale Performance in jeder Region.

Kontrollierte Testumgebung

Synthetische Tests laufen unter gleichbleibenden Bedingungen – inklusive stabiler Netzwerkverbindungen, identischer Browserkonfigurationen und festgelegter Testparameter. Diese Konsistenz ermöglicht genaue Leistungsanalysen und zuverlässiges Cache-Warming.

Echte Browser-Simulation

Fortschrittliches synthetisches Monitoring verwendet reale Browser (Chrome, Firefox, Safari), um Tests durchzuführen. So wird sichergestellt, dass das Cache-Warming dem echten Nutzerverhalten entspricht und dieselben Cache-Mechanismen auslöst.

Wie synthetisches Monitoring CDN-Caches aufwärmt

Der Einsatz synthetischen Monitorings für CDN-Warm-up umfasst mehrere strategische Komponenten:

Strategie zur geografischen Verteilung

Effektives CDN-Warm-up erfordert synthetische Agenten, die auf Schlüsselregionen weltweit verteilt sind. Ziel ist es, dass jeder wichtige CDN-Edge-Standort regelmäßig synthetischen Traffic erhält:

- Primärmärkte: Große Städte und hochfrequentierte Regionen sollten alle 5–15 Minuten überwacht werden, um eine konstante Cache-Wärme zu garantieren.

- Sekundärmärkte: Mittelgroße Märkte und regionale Zentren profitieren von Monitoring alle 15–30 Minuten, was Aktualität und Ressourcennutzung ausbalanciert.

- Wachstumsregionen: Selbst verkehrsarme Regionen sollten alle 30–60 Minuten synthetisch überwacht werden, um gelegentliche Besucher nicht mit kalten Caches zu konfrontieren.

Content-Priorisierung

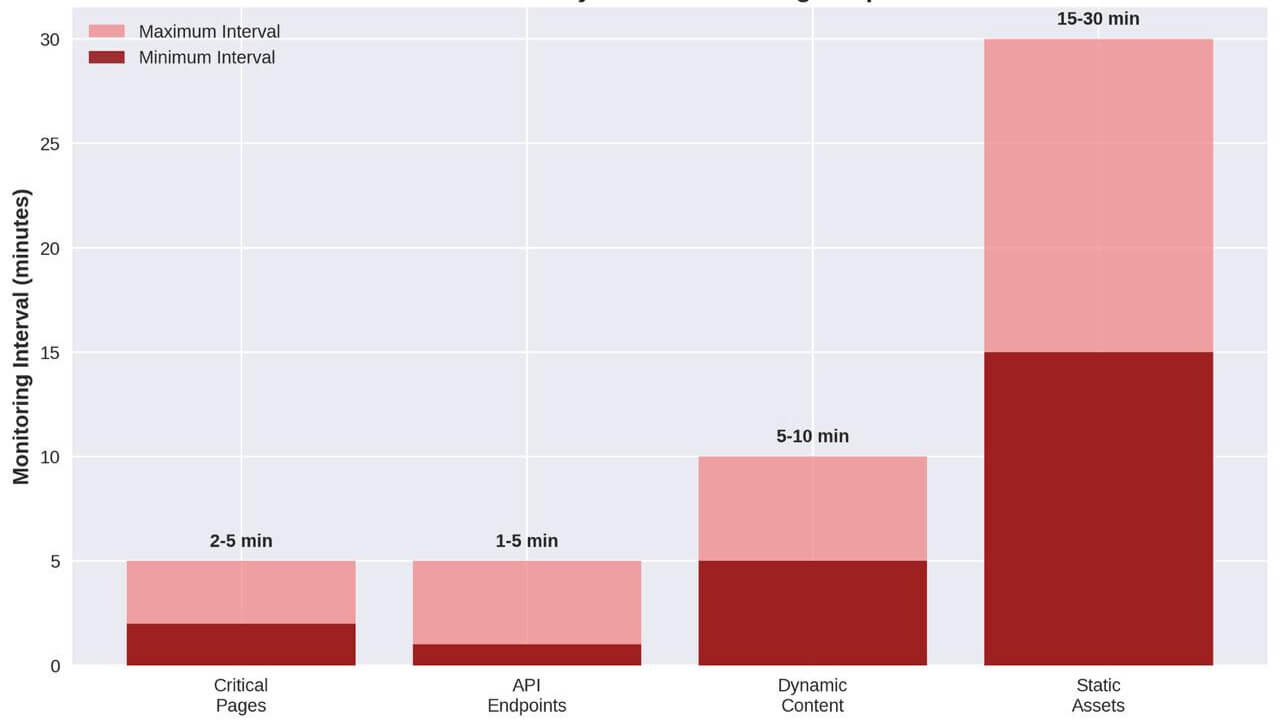

Nicht alle Inhalte benötigen gleich häufiges Cache-Warming. Eine strategische Priorisierung erfolgt nach geschäftlicher Relevanz und Einfluss auf die Nutzererfahrung:

- Kritische Ressourcen: Inhalte der Startseite, Hauptnavigation und Kernfunktionen sollten alle 2–5 Minuten synthetisch getestet werden.

- Dynamische Inhalte: API-Endpunkte, personalisierte Inhalte und häufig aktualisierte Ressourcen sollten alle 5–10 Minuten überwacht werden.

- Statische Assets: CSS-, JavaScript- und Bilddateien benötigen meist nur alle 15–30 Minuten eine Auffrischung, da sie längere TTL-Werte haben.

- Long-Tail-Inhalte: Weniger kritische Seiten und Assets können alle 30–60 Minuten aufgefrischt werden, um Ressourcen zu schonen.

Optimierung von Timing und Frequenz

Das Timing von synthetischem Monitoring für CDN-Warm-up sollte mehrere Faktoren berücksichtigen:

- Abgleich mit TTL-Werten: Die Monitoring-Frequenz sollte sich an den TTL-Einstellungen der Inhalte orientieren, um Cache-Verfall zu vermeiden. Bei einer TTL von 1 Stunde sollte alle 45 Minuten synthetisch überwacht werden.

- Traffic-Muster: In Hochverkehrszeiten kann häufigeres Monitoring nötig sein, während in Nebenzeiten geringere Frequenzen ausreichen.

- Ressourcenschonung: Häufigeres Monitoring verbessert die Cache-Wärme, erzeugt aber auch mehr Origin-Anfragen. Die optimale Frequenz findet ein Gleichgewicht zwischen Leistung und Aufwand.

Dotcom-Monitor: Eine umfassende Lösung

Dotcom-Monitor bietet eine leistungsfähige Plattform zur Umsetzung von CDN-Warm-up-Strategien mittels synthetischen Monitorings. Die Plattform bietet mehrere Funktionen speziell für das Cache-Warming:

Globales Monitoring-Netzwerk

Dotcom-Monitor betreibt über 30 Monitoring-Agenten weltweit – für flächendeckende Abdeckung aller CDN-Edge-Standorte. So wird sichergestellt, dass Inhalte weltweit schnell bereitstehen.

Tests mit echten Browsern

Die Plattform nutzt reale Browser (Chrome, Firefox, Internet Explorer, Safari) für die Ausführung synthetischer Tests. Das ist essenziell, da damit die gleichen Cache-Mechanismen, JavaScript-Ausführungen und Ladevorgänge angestoßen werden wie bei echten Nutzern.

Flexible Zeitplanoptionen

Dotcom-Monitor erlaubt individuelle Zeitpläne für jede Teststrecke – von 1 Minute bis zu mehreren Stunden, mit unterschiedlichen Frequenzen je nach Content-Typ und Region.

Umfassende Leistungsmetriken

Neben dem Cache-Warming bietet Dotcom-Monitor detaillierte Performance-Daten zur CDN-Optimierung. Dazu zählen:

- Time to First Byte (TTFB): Erkennt kalte Caches und misst die Reaktionsgeschwindigkeit von CDN-Edge-Servern.

- Seitenladezeit: Liefert vollständige Einblicke in das Nutzererlebnis – auch im Hinblick auf den Effekt des Cache-Warmings.

- Ressourcenbezogene Ladezeiten: Zeigt Timing einzelner Dateien zur gezielten Optimierung.

- Geografischer Leistungsvergleich: Identifiziert Regionen mit schwächerer Performance – als Hinweis für zusätzliches Cache-Warming.

Erweiterte Skriptfunktionen

Für komplexe Anwendungen unterstützt Dotcom-Monitor fortschrittliches Scripting – zur Simulation anspruchsvoller Nutzerpfade. Besonders wertvoll ist das für dynamische Inhalte, die spezielle Interaktionen oder Logins erfordern.

Umsetzung von synthetischem Monitoring für CDN-Warm-up

Eine erfolgreiche Implementierung folgt einem strukturierten Ablauf:

Phase 1: Analyse und Planung

Zunächst wird die aktuelle CDN-Performance analysiert, um kalte Caches und geografische Schwächen zu identifizieren:

- Performance-Basislinie: Ermittlung aktueller TTFB-Werte, Cache-Hit-Raten und regionaler Unterschiede.

- Content-Inventar: Auflistung aller Inhalte, ihrer Relevanz und bestehenden Caching-Konfigurationen.

- Traffic-Analyse: Auswertung der Zugriffsmuster nach Region und Tageszeit als Basis für Zeitpläne.

Phase 2: Strategieentwicklung

Entwicklung eines vollständigen Monitoring-Konzepts auf Basis der Analyse:

- Geografische Abdeckung: Zuordnung synthetischer Teststandorte zu CDN-Edges für flächendeckende Präsenz.

- Content-Priorisierung: Monitoring-Frequenzen je nach Inhalt und geschäftlicher Relevanz festlegen.

- Zeitplanoptimierung: Zeitpläne im Einklang mit TTLs und Traffic-Mustern gestalten.

Phase 3: Implementierung und Test

Einführung der Tests mit begleitender Validierung:

- Schrittweiser Rollout: Beginnen mit den kritischsten Inhalten und Regionen mit dem größten Impact.

- Performance-Validierung: Laufende Auswertung der Wirkung auf Cache-Hit-Raten und Ladezeiten.

- Optimierung: Anpassung der Frequenzen und Standorte je nach beobachteter Wirkung.

Phase 4: Fortlaufende Optimierung

Regelmäßige Anpassung der Strategie entsprechend neuer Anforderungen:

- Performance-Trend-Analyse: Laufende Auswertung zur Identifikation von Verbesserungspotenzial.

- Content-Änderungen: Monitoring-Konfigurationen bei neuen Inhalten oder strukturellen Änderungen anpassen.

- Saisonale Schwankungen: Zeitpläne an saisonale Traffic-Muster und Geschäftszyklen anpassen.

Die strategische Implementierung von synthetischem Monitoring für CDN-Warm-up legt die Grundlage für dauerhaft exzellente Leistung über alle Regionen und Inhalte hinweg. Im nächsten Abschnitt betrachten wir konkrete Best Practices zur Maximierung der Wirksamkeit dieses Ansatzes.

Best Practices für die Implementierung

Die Umsetzung einer effektiven CDN-Warm-up-Strategie mithilfe von synthetischem Monitoring erfordert sorgfältige Planung und Durchführung. In diesem Abschnitt finden Sie detaillierte Empfehlungen für Best Practices zur Maximierung der Effektivität Ihrer Cache-Warming-Maßnahmen.

Identifikation kritischer Inhalte für das Warm-up

Nicht alle Inhalte benötigen den gleichen Grad an Cache-Warming. Ein strategischer Ansatz konzentriert Ressourcen auf die einflussreichsten Inhalte:

Kritische Pfadanalyse

Beginnen Sie mit einer Analyse des kritischen Pfads, um die Ressourcen zu identifizieren, die die Nutzererfahrung am stärksten beeinflussen:

- Kern-HTML-Dokumente: Startseite, Produktseiten und stark frequentierte Landingpages bilden die Basis der Nutzererfahrung und sollten priorisiert werden.

- Render-blockierende Ressourcen: CSS- und JavaScript-Dateien, die das Rendering blockieren, sollten intensiv aufgewärmt werden, um TTI und FCP zu minimieren.

- Largest Contentful Paint (LCP)-Elemente: Inhalte wie Hero-Bilder oder Above-the-Fold-Elemente, die das LCP beeinflussen, wirken sich direkt auf die wahrgenommene Performance aus.

- API-Endpunkte: Für dynamische Anwendungen sollten API-Endpunkte, die wichtige Daten liefern, besonders bei Edge-Caching in das Warm-up einbezogen werden.

Content-Kategorisierungsmatrix

Organisieren Sie Inhalte in Kategorien basierend auf geschäftlicher Relevanz und Caching-Eigenschaften:

| Inhaltskategorie | Geschäftlicher Einfluss | Cache-TTL | Empfohlene Warm-up-Frequenz |

|---|---|---|---|

| Kritischer Pfad | Sehr hoch | 1–4 Stunden | Alle 2–5 Minuten |

| Primäre Assets | Hoch | 4–24 Stunden | Alle 5–15 Minuten |

| Sekundäre Assets | Mittel | 1–7 Tage | Alle 15–30 Minuten |

| Long-Tail-Inhalte | Niedrig | 7+ Tage | Alle 30–60 Minuten |

Diese Kategorisierung bietet ein Rahmenwerk zur effizienten Verteilung synthetischer Monitoring-Ressourcen bei gleichzeitiger Sicherstellung umfassender Abdeckung.

Optimierung der CDN-Konfiguration für Warm-up

Effektives Cache-Warming erfordert geeignete CDN-Einstellungen, die den Prozess unterstützen:

Optimierung von Cache-Control-Headern

Konfigurieren Sie Cache-Control-Header, um effizientes Caching bei gleichzeitiger Aktualität sicherzustellen:

Cache-Control: public, max-age=3600, s-maxage=86400, stale-while-revalidate=43200

Diese Konfiguration:

- Macht Inhalte öffentlich cachebar (

public) - Setzt Browser-Cache-TTL auf 1 Stunde (

max-age=3600) - Setzt CDN-Cache-TTL auf 24 Stunden (

s-maxage=86400) - Erlaubt Auslieferung veralteter Inhalte während Revalidierung (

stale-while-revalidate=43200)

Der Parameter stale-while-revalidate ist besonders wertvoll für Cache-Warming, da er die sofortige Auslieferung ermöglicht, während im Hintergrund aktualisiert wird – Cache-Misses werden so vermieden.

Anpassung der Cache-Keys

Optimieren Sie CDN-Cache-Keys für maximale Effizienz bei korrekter Inhaltsauslieferung:

- Unnötige Parameter ausschließen: Entfernen Sie Parameter wie Tracking-Codes aus dem Cache-Key.

- Vary-Header selektiv einsetzen: Verwenden Sie z. B.

Vary: Accept-Encoding, aber vermeiden Sie unnötige Variantenbildung. - Cache-Key-Normalisierung: Gleichen Sie URLs an (z. B.

/produktvs./produkt/), um Fragmentierung zu vermeiden.

Edge-Logik für dynamische Inhalte

Für dynamische Inhalte, die normalerweise nicht gecacht werden:

- Edge Side Includes (ESI): Cachebare Templates mit dynamischen Einsprengseln kombinieren.

- Surrogate Keys: Zielgerichtetes Invalidieren einzelner Inhalte ohne kompletten Cache-Purge.

- Cache-Segmentierung: Caches nach Nutzergruppen segmentieren (z. B. eingeloggte Nutzer, Geografie).

Effektives Design synthetischer Monitoring-Tests

Die Gestaltung der Tests beeinflusst unmittelbar die Effektivität des Cache-Warmings:

Realistische Nutzersimulation

Tests sollten echtes Nutzerverhalten simulieren:

- Alle Ressourcen laden: Auch via JavaScript nachgeladene Inhalte einschließen.

- Interaktionen simulieren: Klicks, Formulareingaben, Scrollen etc. auslösen – besonders bei SPAs.

- Variationen von Geräten und Browsern: Unterschiedliche User Agents einbinden, um Varianten zu wärmen.

Strategie zur geografischen Verteilung

Anpassung an Traffic-Muster und Edge-Verteilung:

- Primärmärkte vollständig abdecken: Mehrere Standorte pro Region verwenden.

- Edge-Zuordnung: Teststandorte direkt an CDN-Edges koppeln.

- Traffic-gewichtete Frequenz: Häufigkeit nach Traffic-Volumen pro Region anpassen.

Optimierung der Monitoring-Frequenz

Die Frequenz sollte sich nach mehreren Faktoren richten:

- TTL-basiertes Scheduling: Vor TTL-Ablauf erneuern.

- Traffic-Zyklen berücksichtigen: Zu Spitzenzeiten häufiger, zu Randzeiten seltener.

- Gestaffelte Ausführung: Tests zeitlich versetzt starten, um Origin-Last zu verteilen.

Umgang mit Sonderfällen und Randbedingungen

Spezielle Inhalte erfordern besondere Warm-up-Maßnahmen:

Deployments und Cache-Purges

Maßnahmen nach Veröffentlichung neuer Inhalte:

- Stufenweises Warm-up: Beginnen mit kritischem Inhalt, dann sukzessive ausweiten.

- Purge-und-Warm-Automatisierung: In CI/CD-Prozesse integrieren.

- Canary-Warming: Zunächst in Teilregionen testen, dann global ausrollen.

Authentifizierte Inhalte

Für Inhalte mit Login:

- Testaccounts: Repräsentative Konten einrichten.

- Token-Rotation: Sichere Authentifizierung regelmäßig aktualisieren.

- Segmentierung: Warm-up je Nutzersegment durchführen.

Geobasierte Inhalte

Bei Inhalten mit regionalen Varianten:

- Regionale Test-Suites: Unterschiedliche Inhalte berücksichtigen.

- IP-Geolocation validieren: Testagenten müssen regional korrekt ausliefern.

- Regelkonformität sicherstellen: Datenschutz und Zugriff nach Vorschrift.

Messung und Validierung der Warm-up-Wirkung

Nur durch Monitoring lassen sich Ergebnisse belegen:

Schlüsselmetriken (KPIs)

Diese Kennzahlen zeigen Erfolg:

- Cache-Hit-Rate: Ziel: >95 % (statisch), >90 % (dynamisch)

- TTFB pro Region: Ziel: <100 ms für gecachte Inhalte

- Origin-Anfragen: Ziel: signifikante Reduktion entsprechend Cache-Hit-Rate

- Performance-Konsistenz: Ziel: <10 % Abweichung zwischen Regionen

Validierungsmethoden

So prüfen Sie die Wirksamkeit:

- A/B-Tests: Vergleich von Regionen mit/ohne Warm-up

- Korrelation mit RUM: Abgleich synthetischer mit echten Nutzerdaten

- Cache-Status-Header: Analyse von Headern wie

X-CacheoderCF-Cache-Status

Fallstudie: Optimierung einer E-Commerce-Plattform

Ein globaler E-Commerce-Anbieter implementierte eine umfassende CDN-Warm-up-Strategie mit synthetischem Monitoring – mit folgenden Ergebnissen:

Ausgangszustand:

- Cache-Hit-Rate: 82 %

- Durchschnittliche TTFB: 220 ms

- Regionale Performance-Abweichung: 35 %

- Origin-Last: Hoch bei Traffic-Spitzen

Vorgehen:

- Monitoring aus 24 globalen Standorten ausgerollt

- Inhalte in vier Prioritätsstufen mit abgestuften Warm-up-Frequenzen eingeteilt

- CDN konfiguriert mit

stale-while-revalidate - Post-Deployment-Warm-up automatisiert

Ergebnisse nach 30 Tagen:

- Cache-Hit-Rate: 98,5 % (+16,5 %)

- Durchschnittliche TTFB: 65 ms (–70 %)

- Regionale Abweichung: 8 % (–77 %)

- Origin-Last: –85 %

- Conversion-Rate: +4,2 %

Diese Fallstudie zeigt die transformative Wirkung einer gut umgesetzten CDN-Warm-up-Strategie auf technische Performance und geschäftlichen Erfolg.

Im nächsten Abschnitt werfen wir einen Blick auf fortgeschrittene Techniken zur Skalierung und weiteren Optimierung dieser Strategien im Enterprise-Umfeld.

Erweiterte Techniken und Skalierungsstrategien

Für Unternehmen im Enterprise-Bereich reichen grundlegende CDN-Warm-up-Strategien oft nicht aus. Komplexe Architekturen, riesige Inhaltsbibliotheken und globale Nutzerbasen erfordern fortgeschrittene Ansätze. In diesem Abschnitt werden hochentwickelte Methoden zur Skalierung und Optimierung des CDN-Warm-ups für Unternehmenseinsätze vorgestellt.

Intelligentes Warm-up mit Machine Learning

Machine Learning kann die Effizienz und Wirksamkeit von CDN-Warm-up-Strategien deutlich steigern, indem es Ressourcenallokation optimiert und Inhaltsbedarfe vorhersagt:

Prädiktives Cache-Warming

Setzen Sie Modelle ein, die künftige Inhaltsabrufe vorhersagen:

- Analyse von Traffic-Mustern: Vergangene Traffic-Daten helfen, zukünftige Anfragen vorherzusagen und gezielt vorzuwärmen.

- Vorhersage der Inhaltsbeliebtheit: Engagement-Metriken identifizieren trendende Inhalte, die priorisiert werden sollten.

- Saisonale Trendmodelle: Berücksichtigen Sie saisonale Schwankungen bei der Content-Nachfrage für dynamische Warm-up-Anpassungen.

Adaptive Frequenzoptimierung

Automatische Anpassung der Warm-up-Frequenzen auf Basis gemessener Performance:

- Performance-gesteuerte Anpassung: Häufigeres Aufwärmen bei hoher Cache-Miss-Rate, seltener bei stabil gecachten Inhalten.

- Kosten-Nutzen-Analyse: Algorithmen balancieren Monitoring-Kosten mit Performance-Gewinn für optimalen ROI.

- Echtzeit-Adaption: Dynamische Anpassung der Strategie auf Grundlage von Traffic, Performance und Serverlast.

Integration in CI/CD-Pipelines

Die nahtlose Einbindung in DevOps-Prozesse macht Cache-Warming zu einem festen Bestandteil des Content-Lifecycles:

Automatisches Warm-up nach Deployments

Implementieren Sie Warm-up-Schritte direkt in Ihren Deployment-Workflow:

- Event-getriggerte Abläufe: CI/CD-Pipelines starten automatisches Warm-up nach erfolgreichem Deployment.

- Content-Diff-Analyse: Nur neu hinzugefügte oder geänderte Inhalte werden gezielt vorgewärmt.

- Progressives Warm-up: Beginnt mit kritischen Inhalten und dehnt sich stufenweise auf die gesamte Site aus.

Canary-Deployments mit Warm-up

Kombinieren Sie Canary-Rollouts mit gezieltem Cache-Warming:

- Abgestimmter Rollout: Cache-Warming erfolgt synchron zum stufenweisen Rollout neuer Inhalte.

- Validierungsgates: Synthetic-Monitoring-Daten dienen als Kriterien für Fortsetzung oder Rücknahme des Deployments.

- Multi-CDN-Synchronisierung: Gleichzeitiges Warm-up über mehrere CDN-Anbieter hinweg sorgt für konstante Performance.

Optimierung im globalen Maßstab

Globale Plattformen benötigen spezielle Techniken zur regionsübergreifenden Optimierung:

Framework zur regionalen Priorisierung

Verteilen Sie Warm-up-Ressourcen basierend auf wirtschaftlicher Bedeutung:

- Wertgewichtung pro Markt: Investitionen in Warm-up proportional zum Marktwert.

- Wachstumsmarkt-Fokus: Erhöhte Warm-up-Frequenz in Expansionsmärkten.

- Ereignisbezogene Anpassung: Vorübergehende Erhöhung während lokaler Events oder Kampagnen.

Strategien für Multi-CDN-Setups

Koordiniertes Warm-up bei mehreren CDN-Anbietern:

- Anbieter-spezifische Optimierung: Berücksichtigung unterschiedlicher Caching-Mechanismen je CDN.

- Redundanz über Anbietergrenzen: Sicherstellen, dass Inhalte auch bei Traffic-Shift warm bleiben.

- Vorbereitung auf Performance-basiertes Routing: Gleichzeitiges Warm-up aller CDNs für Lastverteilung nach Leistung.

Ressourcenschonung im Enterprise-Bereich

Bei großem Umfang ist effiziente Ressourcennutzung entscheidend:

Gestufte Warm-up-Strategien

Kombinieren Sie flächendeckende Abdeckung mit Effizienz:

- Sättigung kritischer Pfade: Sehr häufiges Warm-up aller kritischen Inhalte aus allen Regionen.

- Repräsentatives Sampling: Sekundäre Inhalte durch repräsentative Teilmengen abdecken.

- Rotation von Long-Tail-Inhalten: Zyklisches Warm-up großer Content-Bibliotheken über Zeit.

Verteilte Ausführungsarchitektur

Verteilen Sie synthetisches Monitoring räumlich und zeitlich:

- Edge-Ausführung: Monitoring-Agenten am Edge für realistische Bedingungen und geringere Latenz.

- Lastverteilung: Überwachung in Zeitfenster streuen, um künstlichen Traffic-Spitzen vorzubeugen.

- Regionale Cluster: Lokale Agentengruppen pro Region zur Optimierung der Netzwerkpfade.

Erweitertes Monitoring und Analytik

Fortgeschrittene Dashboards und KI-gestützte Analysen ermöglichen feingranulare Optimierung:

Leistungsdashboards mit Überblick

Visualisieren Sie Effekte und Trends:

- Globale Heatmaps: Performance visuell nach Regionen auswerten.

- Korrelationsanalysen: Zusammenhang zwischen Warm-up-Aktivität und Performance messen.

- Trendanalysen: Langfristige Entwicklungen erkennen und adaptieren.

Anomalie-Erkennung und Benachrichtigung

Erkennen Sie Fehler oder Ausfälle frühzeitig:

- Mustererkennung: KI erkennt Abweichungen, die auf Fehler oder Cache-Probleme hinweisen.

- Proaktive Alerts: Warnmeldungen basierend auf Frühindikatoren aus dem Monitoring.

- Automatisierte Behebung: Reaktions-Workflows zur Anpassung oder Wiederholung des Warm-ups.

Fallstudie: Globale Medienplattform

Ein Medienanbieter mit über 50 Mio. täglichen Nutzern implementierte eine hochentwickelte CDN-Warm-up-Strategie:

Ausgangsprobleme:

- Inhaltsbibliothek >500 TB mit häufigen Updates

- Publikum in über 190 Ländern

- Mehrere CDN-Anbieter mit unterschiedlichen Caching-Verhalten

- Saisonale Lastspitzen mit dem 10-fachen des Normalvolumens

Umsetzung:

- Machine-Learning-Modelle zur Inhaltsprognose und Priorisierung eingesetzt

- CI/CD-Integration für automatisiertes Post-Deployment-Warm-up

- Gestufte Warm-up-Strategie mit kritischer Pfad-Abdeckung und Long-Tail-Rotation

- Cross-CDN-Orchestrierung für konsistente Performance

Ergebnisse:

- 99,3 % Cache-Hit-Rate weltweit

- 94 % weniger Origin-Traffic bei Events

- <5 % Performance-Abweichung zwischen Regionen

- TTFB <100 ms bei 99,7 % der Anfragen

- 32 % Infrastrukturkostenersparnis

Diese Fallstudie zeigt, wie hochentwickelte Warm-up-Techniken selbst größte Plattformen leistungsfähig und effizient skalieren lassen.

Zukunftstrends im CDN-Warm-up

Neue Technologien eröffnen weitere Optimierungsmöglichkeiten:

Integration von Edge Computing

Mit wachsender Edge-Leistung wird das Warm-up erweitert auf:

- Edge-Function-Warming: Vorab-Ausführung von Funktionen zur Aufwärmung von Rechenoperationen.

- Edge-Datenbank-Warming: Einbindung von Caches auf Edge-Datenbanken in die Strategie.

- Preprocessing am Edge: Reduktion der Nutzerlatenz durch Vorverarbeitung beim Warm-up.

KI-gesteuerte Optimierung

Künstliche Intelligenz wird zentrale Rolle bei Steuerung spielen:

- Verhaltensprognose: Vorhersage konkreter Nutzerpfade zur gezielten Journey-Wärmung.

- Autonome Optimierung: Selbstlernende Systeme passen Strategien ohne Eingriff an.

- Plattformübergreifende Koordination: Omnichannel-Warm-up für Web, App & Co.

Diese fortgeschrittenen Methoden und künftigen Entwicklungen zeigen, wie CDN-Warm-up zur Hochleistungsstrategie auf globalem Niveau weiterentwickelt werden kann – für maximale Performance bei optimalem Ressourceneinsatz.

Fazit: CDN-Performance durch proaktives Warm-up transformieren

Content Delivery Networks haben die Web-Performance revolutioniert, indem sie Inhalte näher an die Nutzer bringen. Doch das grundlegende Problem kalter Caches ist eine beständige Einschränkung geblieben. Wie wir in dieser technischen Analyse gesehen haben, bietet synthetisches Monitoring eine wirkungsvolle Lösung für diese Herausforderung und ermöglicht es Unternehmen, ihre CDNs von reaktiven Caching-Systemen in proaktive Performance-Beschleuniger zu verwandeln.

Die Vorteile einer umfassenden CDN-Warm-up-Strategie gehen weit über technische Leistungskennzahlen hinaus. Durch das Eliminieren von Cold-Cache-Nachteilen können Unternehmen durchgängig herausragende Nutzererfahrungen bieten – mit direktem Einfluss auf den Geschäftserfolg:

- Höhere Konversionsraten: Schnellere und konsistentere Performance führt zu mehr Conversions in allen Märkten.

- Stärkeres Nutzerengagement: Geringere Latenz erhöht die Verweildauer und den Content-Konsum.

- Positiveres Markenimage: Gleichmäßige globale Performance schafft ein hochwertiges Nutzererlebnis – unabhängig vom Standort.

- Niedrigere Infrastrukturkosten: Höhere Cache-Hit-Raten entlasten Ursprungsserver und senken Infrastrukturkosten erheblich.

- Höhere betriebliche Resilienz: Proaktiv vorgewärmte Caches schützen bei Lastspitzen und betrieblichen Herausforderungen.

Die Umsetzung des CDN-Warm-ups durch synthetisches Monitoring markiert den Übergang von reaktiver zu proaktiver Performance-Optimierung. Anstatt auf Nutzerfeedback zu warten, können Unternehmen die Performance bereits im Vorfeld absichern. Dieser Ansatz entspricht den heutigen Erwartungen an Nutzererlebnisse, bei denen selbst Millisekunden Verzögerung spürbare Auswirkungen haben.

Mit zunehmender Komplexität und globaler Reichweite moderner Webanwendungen steigt die Bedeutung von CDN-Warm-up weiter. Unternehmen, die auf fortgeschrittene Warm-up-Strategien setzen, verschaffen sich entscheidende Wettbewerbsvorteile – durch bessere Performance, geringere Kosten und zufriedenere Nutzer.

Der Weg zur optimalen CDN-Leistung beginnt mit einem einfachen Schritt: der Implementierung von Basis-Monitoring für die wichtigsten Inhalte. Von dort aus können Strategien schrittweise erweitert und mit fortgeschrittenen Methoden skaliert werden – bis hin zur Abdeckung selbst der komplexesten globalen Systeme.

Durch die Nutzung von CDN-Warm-up mittels synthetischem Monitoring optimieren Sie nicht nur einen technischen Wert – Sie transformieren das Erlebnis, das Sie jedem einzelnen Nutzer weltweit bieten.

Quellen

- Kissmetrics, „Wie sich Ladezeiten auf Ihre Conversion auswirken“, https://neilpatel.com/blog/loading-time/

- Cloudflare, „Was ist Edge Computing?“ https://www.cloudflare.com/learning/cdn/glossary/edge-server/

- Web.dev, „Web Vitals“, https://web.dev/vitals/

- Akamai, „Cache Hit Ratio: Der Schlüssel zu zufriedenen Nutzern und geringeren Kosten“, https://www.akamai.com/blog/edge/the-key-metric-for-happier-users

- Kinsta, „WordPress CDN – Ladezeiten mit CDN um bis zu 72 % verbessern“, https://kinsta.com/blog/wordpress-cdn/

- Dotcom-Monitor, „CDNs mit synthetischem Monitoring optimieren“, https://www.dotcom-monitor.com/blog/optimize-cdns-with-synthetic-monitoring/

- Akamai, „Cache-Control-Header verstehen“, https://developer.akamai.com/blog/2020/09/25/understanding-cache-control-headers

- Google Developers, „Largest Contentful Paint (LCP)“, https://web.dev/lcp/

- MDN Web Docs, „Stale-While-Revalidate“, https://developer.mozilla.org/en-US/docs/Web/HTTP/Headers/Cache-Control#stale-while-revalidate

- Fastly, „Edge Side Includes (ESI) Language Specification“, https://www.fastly.com/documentation/guides/esi-use

Spitzenlasten auf dem Ursprungsserver

Spitzenlasten auf dem Ursprungsserver