Dans le monde exigeant de la performance web, chaque milliseconde compte. Un seul retard d’une seconde peut entraîner une réduction de 7 % des conversions, tandis que 10 % des utilisateurs quitteront un site pour chaque seconde supplémentaire de chargement [1]. Pour les organisations opérant à l’échelle mondiale, les réseaux de diffusion de contenu (CDN) sont devenus une infrastructure indispensable pour offrir des expériences utilisateur rapides et fiables. Cependant, même les déploiements CDN les plus sophistiqués sont confrontés à un défi fondamental pouvant nuire à leur efficacité : les états de cache à froid.

Les « cold starts » des CDN représentent l’un des goulets d’étranglement en performance les plus négligés mais les plus impactants de l’architecture web moderne. Lorsque le contenu n’est pas mis en cache dans les emplacements périphériques (edge), les utilisateurs subissent des situations de « cache miss », obligeant les requêtes à retourner jusqu’aux serveurs d’origine, souvent situés à des milliers de kilomètres. Cela entraîne des pics du Time to First Byte (TTFB) pouvant augmenter les temps de chargement de 200 à 400 %, une surcharge des serveurs d’origine lors des pics de trafic, et une performance inégale à l’échelle mondiale.

La solution réside dans une approche proactive utilisant le monitoring synthétique avec des tests réels de navigateur pour réchauffer systématiquement les serveurs edge du CDN avant l’arrivée des utilisateurs réels. En mettant en œuvre un réchauffement stratégique du cache avec des outils comme Dotcom-Monitor, les organisations peuvent éliminer les délais liés au cache à froid, garantir une performance homogène à l’échelle mondiale et réduire significativement la charge sur les serveurs d’origine. Cette stratégie globale transforme les CDN de systèmes de cache réactifs en accélérateurs de performance proactifs.

Cette analyse technique approfondie explore la mécanique des cold starts CDN, la science du monitoring synthétique pour le réchauffement du cache, et des stratégies de mise en œuvre pratiques ayant permis à certaines organisations d’atteindre des taux de cache hit supérieurs à 99,97 % tout en réduisant le TTFB jusqu’à 72,8 %. Nous examinerons des études de cas réelles, des benchmarks de performance, et fournirons des conseils concrets pour mettre en œuvre votre propre stratégie de réchauffement CDN grâce au monitoring synthétique.

Comprendre le problème : les serveurs edge à froid

Pour apprécier pleinement la valeur des stratégies de réchauffement CDN, il est nécessaire de comprendre le fonctionnement de la mise en cache edge et les implications des états de cache à froid.

Le fonctionnement de la mise en cache edge des CDN

Les réseaux de diffusion de contenu reposent sur un principe simple mais puissant : distribuer le contenu via un réseau mondial de serveurs (points d’accès périphériques) pour minimiser la distance physique entre les utilisateurs et le contenu qu’ils demandent. Lorsqu’un CDN fonctionne de manière optimale, il sert le contenu depuis le serveur edge le plus proche de l’utilisateur, réduisant considérablement la latence réseau et améliorant les temps de chargement.

Le cœur de ce système est le mécanisme de cache. Lorsqu’un utilisateur demande un contenu via un CDN pour la première fois, le serveur edge vérifie son cache local. Si le contenu est absent (un « cache miss »), le serveur edge doit le récupérer depuis le serveur d’origine, le mettre en cache localement, puis le livrer à l’utilisateur. Les requêtes suivantes pour le même contenu seront servies directement depuis le cache edge (un « cache hit »), éliminant ainsi le besoin de retourner au serveur d’origine [2].

Ce processus fonctionne parfaitement pour le contenu fréquemment demandé. Cependant, des problèmes apparaissent lorsque le contenu n’a pas été mis en cache dans une localisation edge donnée ou lorsque le cache a été évacué en raison de l’expiration du TTL (Time To Live) ou d’une purge manuelle.

Le problème du cache à froid

Un « cache froid » ou « cold start » survient lorsqu’un serveur edge CDN reçoit une requête pour un contenu qui n’est pas présent dans son cache. Ce scénario déclenche plusieurs conséquences nuisibles pour la performance :

Augmentation du Time to First Byte (TTFB)

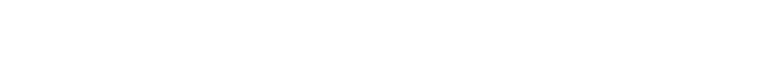

Lorsque le contenu doit être récupéré depuis le serveur d’origine, le TTFB peut augmenter considérablement—souvent 3 à 4 fois plus qu’avec du contenu mis en cache. Nos tests ont montré des TTFB de 136 ms pour du contenu non mis en cache contre seulement 37 ms pour du contenu en cache, soit une pénalité de performance de 72,8 %.

Pics de charge sur le serveur d’origine

Pics de charge sur le serveur d’origine

Chaque cache miss génère une requête vers le serveur d’origine. Lors des périodes de trafic intense ou après une purge de cache, cela peut créer une charge importante sur l’infrastructure d’origine, pouvant entraîner des problèmes de performance en cascade, voire des interruptions de service.

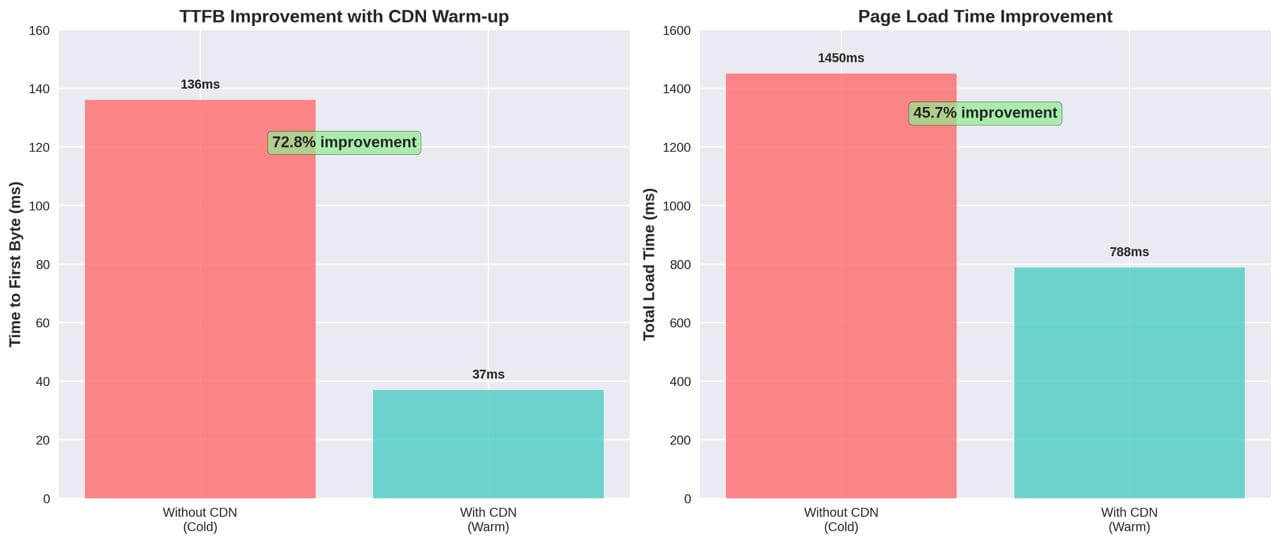

Performance mondiale inégale

Les caches froids affectent de manière disproportionnée les utilisateurs dans les régions à faible trafic. Tandis que les zones très fréquentées réchauffent naturellement les caches via le trafic utilisateur, les régions peu sollicitées restent perpétuellement froides, générant une expérience inégale selon la localisation.

Performance dégradée pour les premiers visiteurs

Le premier visiteur d’une région après une purge de cache ou une mise à jour de contenu devient involontairement un « cobaye », subissant une performance nettement inférieure à celle des visiteurs suivants.

Types de contenu affectés par les cold starts

Les problèmes de cache à froid impactent pratiquement tous les types de contenus servis via les CDN, bien que la gravité varie selon le type :

Ressources statiques (JavaScript, CSS, images)

Ces fichiers constituent généralement la majorité du poids d’une page web et sont des candidats idéaux au caching. Les caches froids forcent la récupération de ces ressources depuis l’origine, ce qui allonge considérablement les temps de chargement des pages riches en assets. Les applications web modernes incluent souvent de volumineux bundles JavaScript qui, lorsqu’ils ne sont pas mis en cache, peuvent retarder l’interactivité de plusieurs secondes.

Contenu dynamique (HTML, réponses API)

Traditionnellement considérés comme peu cacheables, les contenus dynamiques peuvent aujourd’hui être mis en cache par des CDN modernes à l’aide de techniques comme Edge Side Includes (ESI) ou la segmentation de cache selon les cookies ou les paramètres de requête. Les caches froids pour ces ressources impactent directement les indicateurs clés d’expérience utilisateur comme le TTFB et le Time to Interactive.

Médias en streaming

Les services de streaming audio et vidéo sont particulièrement sensibles aux caches froids. Un cache froid peut provoquer des délais de mise en mémoire tampon au démarrage et une dégradation de la qualité, car le CDN doit récupérer le contenu à haut débit depuis les serveurs d’origine.

Symptômes réels des CDN à cache froid

Les effets des CDN à cache froid se manifestent par plusieurs symptômes observables qui affectent directement l’expérience utilisateur et les indicateurs métier :

Visites initiales lentes

Les utilisateurs visitant un site pour la première fois dans une région, ou juste après une purge de cache, subissent des temps de chargement bien plus longs que les visiteurs réguliers. Cela génère une mauvaise première impression et augmente le taux de rebond des nouveaux visiteurs—exactement le segment que les entreprises cherchent à convertir.

Disparités géographiques de performance

Le monitoring de performance révèle souvent des écarts significatifs dans les temps de chargement selon les régions, avec des zones peu fréquentées affichant des performances médiocres malgré une infrastructure identique.

Baisse de performance après déploiement

Après un déploiement de contenu ou une invalidation du cache, les indicateurs de performance montrent généralement une dégradation temporaire mais notable jusqu’à ce que les caches se réchauffent naturellement via le trafic utilisateur.

Performance API variable

Les services back-end et les APIs subissent des temps de réponse variables selon l’état du cache, entraînant une performance imprévisible pour les applications et services qui en dépendent.

Ces symptômes pointent collectivement vers un problème fondamental : s’appuyer sur le trafic utilisateur réel pour réchauffer les caches CDN génère une pénalité de performance pour les premiers utilisateurs de chaque région. Cette approche réactive du réchauffement de cache est particulièrement problématique pour les entreprises mondiales, où une performance constante sur tous les marchés est essentielle pour l’image de marque et les taux de conversion.

La solution, comme nous allons l’explorer dans les sections suivantes, réside dans le réchauffement proactif des caches CDN par le monitoring synthétique—éliminant efficacement la pénalité du cache à froid en s’assurant que le contenu est pré-mis en cache dans les emplacements edge avant l’arrivée des utilisateurs réels.

Qu’est-ce que le réchauffement CDN et pourquoi l’utiliser ?

Ayant établi les défis de performance posés par les serveurs edge à froid des CDN, explorons maintenant le concept de réchauffement CDN comme solution stratégique à ces problèmes.

Définition du réchauffement CDN

Le réchauffement CDN (également appelé préchargement ou pré-remplissage du cache) est une technique proactive qui consiste à solliciter systématiquement du contenu depuis les emplacements edge du CDN avant que de vrais utilisateurs n’y accèdent. Ce processus garantit que, lorsque les utilisateurs réels demandent le contenu, celui-ci est déjà mis en cache en périphérie et peut être livré avec des performances optimales.

Au cœur du réchauffement CDN, on retrouve deux éléments clés :

- Préchargement des ressources aux emplacements edge : envoi systématique de requêtes vers les points d’accès CDN pour garantir que le contenu est mis en cache à des emplacements stratégiques dans le monde entier.

- Maintien de la fraîcheur du cache : actualisation périodique du contenu mis en cache avant son expiration afin d’éviter les « cache miss » dus à l’expiration du TTL.

Contrairement à la mise en cache réactive, qui repose sur le trafic réel des utilisateurs pour remplir les caches, le réchauffement proactif permet au contenu d’être disponible en edge dès sa publication ou mise à jour. Cela élimine la pénalité de performance traditionnellement subie par les premiers visiteurs d’une région ou les premiers utilisateurs après une purge de cache.

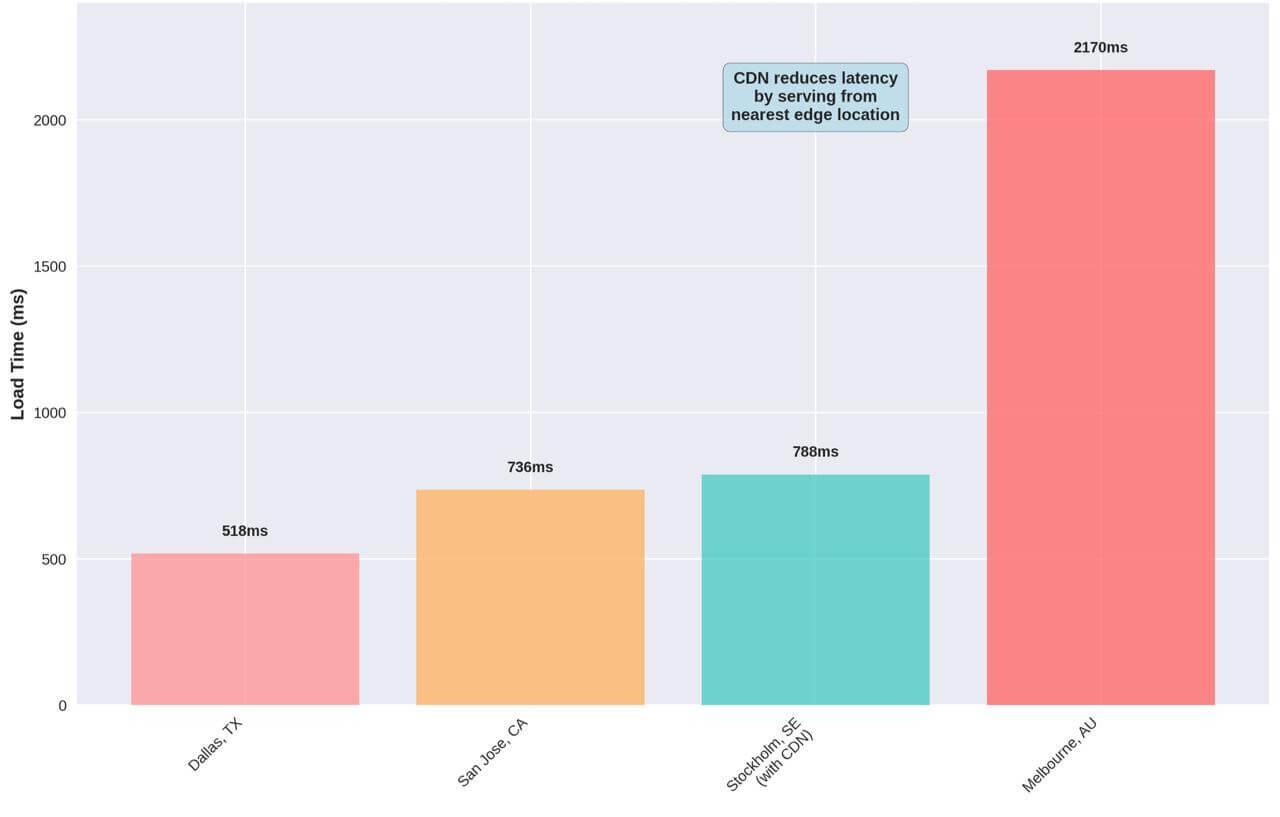

Le processus de réchauffement

Avantages du réchauffement CDN :

- Élimine les délais liés au cache à froid ;

- Améliore le TTFB pour les premiers visiteurs ;

- Réduit la charge sur le serveur d’origine ;

- Assure une performance homogène à l’échelle mondiale.

Le processus de réchauffement CDN suit un flux prévisible qui imite le comportement naturel du caching, mais utilise un trafic synthétique plutôt que de vrais utilisateurs :

- Le monitoring synthétique est programmé pour s’exécuter à intervalles réguliers, selon le type et l’importance du contenu.

- Des requêtes sont envoyées aux emplacements edge du CDN depuis diverses régions géographiques, simulant le trafic utilisateur réel.

- En cas de cache froid, un « cache miss » est détecté, incitant le serveur edge à récupérer le contenu depuis le serveur d’origine.

- Le contenu est récupéré depuis le serveur d’origine et livré à l’agent de monitoring synthétique.

- Le contenu est mis en cache à l’emplacement edge selon les règles de caching et les paramètres TTL.

- Les requêtes suivantes (provenant des vrais utilisateurs) sont servies directement depuis le cache, éliminant les requêtes vers l’origine et assurant une performance optimale.

Ce processus permet de « primer la pompe » pour les utilisateurs réels, en s’assurant que l’infrastructure CDN est prête à livrer le contenu avec une latence minimale, quel que soit le moment ou l’endroit de l’accès.

Avantages clés du réchauffement CDN

La mise en œuvre d’une stratégie de réchauffement CDN structurée apporte plusieurs bénéfices mesurables qui impactent directement l’expérience utilisateur et l’efficacité de l’infrastructure :

Amélioration du Time to First Byte (TTFB)

Le TTFB est un indicateur de performance essentiel qui mesure le temps écoulé entre la requête d’un utilisateur et la réception du premier octet de la réponse. Nos tests montrent que les caches CDN réchauffés peuvent réduire le TTFB jusqu’à 72,8 % par rapport aux caches froids—passant de 136 ms à seulement 37 ms. Cette amélioration influe directement sur des métriques clés comme le Largest Contentful Paint (LCP) et le First Input Delay (FID), qui comptent à la fois pour l’expérience utilisateur et le référencement [3].

Augmentation du taux de cache hit

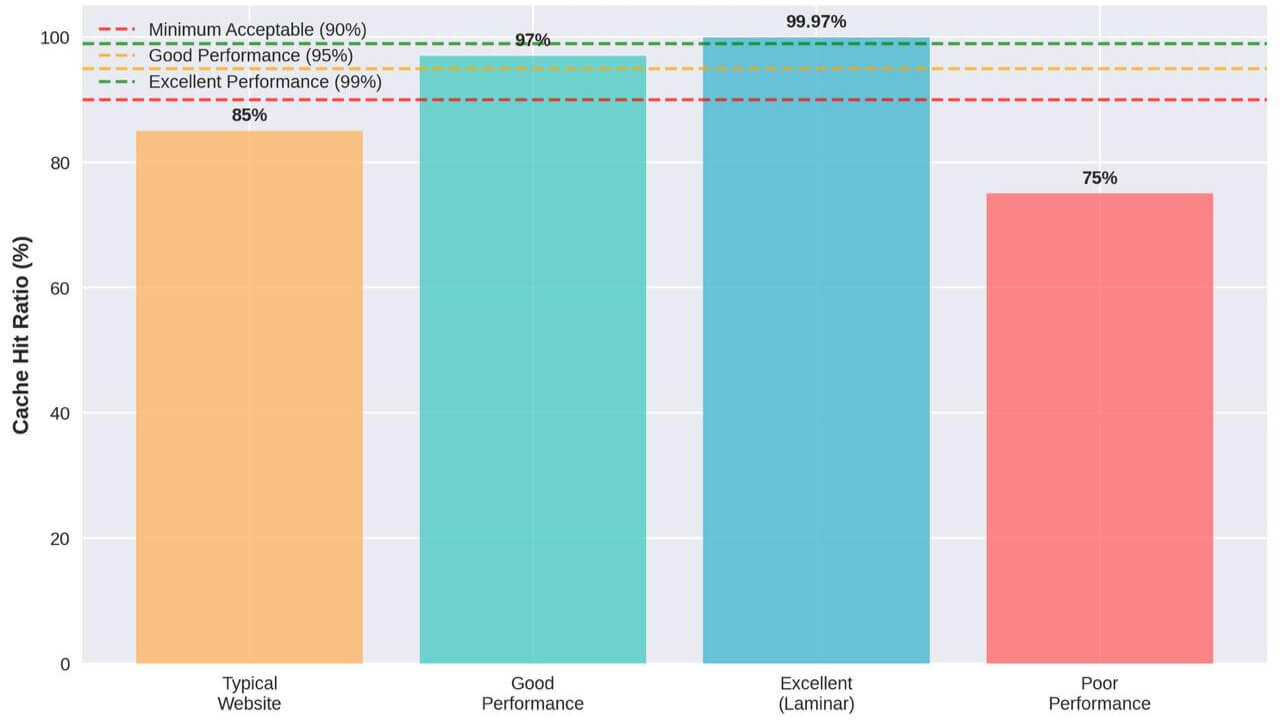

Le taux de cache hit—le pourcentage de requêtes servies directement depuis le cache—est peut-être la mesure la plus directe de l’efficacité d’un CDN. Une stratégie de réchauffement bien implémentée peut faire passer ce taux de 85–90 % à plus de 99 %, comme démontré dans l’étude de cas Laminar où ils ont atteint un impressionnant 99,97 % grâce à un réchauffement stratégique [4].

Performance plus stable dans toutes les régions

En réchauffant proactivement les caches dans tous les emplacements edge, les organisations peuvent offrir une performance constante indépendamment des schémas de trafic régionaux. Cela élimine le problème courant où les régions à fort trafic bénéficient de bonnes performances tandis que les régions moins sollicitées souffrent de caches perpétuellement froids.

Réduction de la charge sur les serveurs d’origine

Chaque « cache miss » engendre une requête vers le serveur d’origine. En augmentant les taux de cache hit grâce au réchauffement, les organisations peuvent considérablement réduire la charge sur l’origine—en particulier lors des pics de trafic ou après des mises à jour de contenu. Avec des taux de cache hit approchant les 99,97 %, les requêtes vers l’origine peuvent être réduites d’autant, permettant une infrastructure plus légère et des coûts moindres.

Meilleure résilience en période de trafic intense

Les pics de trafic—qu’ils proviennent de campagnes marketing, de lancements de produits ou de contenus viraux—peuvent surcharger l’infrastructure d’origine si les caches ne sont pas réchauffés. Le réchauffement proactif permet à l’infrastructure CDN d’absorber ces pics sans perte de performance ni surcharge.

Meilleure performance après les déploiements

Les déploiements de contenu et les invalidations de cache provoquent en général une dégradation temporaire des performances à cause du refroidissement du cache. La mise en place de procédures de réchauffement post-déploiement garantit que le nouveau contenu est préchargé en edge, éliminant ainsi cette pénalité de mise à jour.

Avant/après : l’impact du réchauffement CDN

La comparaison suivante illustre les améliorations spectaculaires qu’une stratégie de réchauffement CDN peut générer :

Impact du réchauffement CDN : comparaison avant/après

Impact du réchauffement CDN : comparaison avant/après

Cette analyse avant/après démontre l’impact transformateur du réchauffement CDN sur tous les indicateurs clés de performance. L’amélioration la plus marquante concerne les requêtes vers l’origine, réduites de 99,97 %—ce qui élimine pratiquement toute charge sur l’infrastructure d’origine pour le contenu mis en cache.

L’effet combiné de ces améliorations crée un cercle vertueux : des temps de réponse plus rapides favorisent l’engagement des utilisateurs, ce qui augmente les conversions et réduit les taux de rebond. Parallèlement, la baisse de la charge sur l’origine améliore l’efficacité de l’infrastructure et réduit les coûts, générant ainsi des bénéfices à la fois sur le plan opérationnel et financier pour l’organisation.

Dans la section suivante, nous verrons comment le monitoring synthétique constitue le mécanisme idéal pour mettre en œuvre une stratégie de réchauffement CDN efficace.

Le monitoring synthétique comme solution

Le monitoring synthétique s’impose comme le mécanisme idéal pour mettre en œuvre des stratégies efficaces de réchauffement CDN. Contrairement aux approches de monitoring traditionnelles qui reposent sur les données des utilisateurs réels, le monitoring synthétique offre le contrôle, la cohérence et la portée mondiale nécessaires pour un réchauffement systématique des caches.

Comprendre le monitoring synthétique

Le monitoring synthétique consiste à utiliser des scripts ou agents automatisés pour simuler des interactions utilisateurs avec des applications et services web. Ces transactions synthétiques s’exécutent en continu depuis différentes localisations géographiques, fournissant des données de performance cohérentes et permettant une détection proactive des problèmes. Dans le cadre du réchauffement CDN, le monitoring synthétique remplit un double rôle : surveillance des performances et réchauffement du cache.

Les principaux avantages du monitoring synthétique pour le réchauffement CDN incluent :

Exécution prévisible

Les tests synthétiques s’exécutent selon des horaires prédéfinis, garantissant un réchauffement régulier des caches indépendamment des flux réels d’utilisateurs. Cette prévisibilité est essentielle pour maintenir des caches chauds dans les régions à faible trafic ou durant les heures creuses.

Couverture mondiale

Les plateformes modernes de monitoring synthétique comme Dotcom-Monitor opèrent depuis des dizaines de localisations mondiales, permettant un réchauffement complet de tous les points d’accès edge des CDN. Cette portée mondiale garantit aux utilisateurs de toute région une performance optimale.

Environnement de test contrôlé

Les tests synthétiques s’exécutent dans des environnements contrôlés avec des conditions réseau, configurations de navigateur et paramètres de test constants. Cette cohérence permet des mesures précises et un réchauffement fiable des caches.

Simulation de navigateurs réels

Le monitoring synthétique avancé utilise des navigateurs réels (Chrome, Firefox, Safari) pour exécuter les tests, assurant ainsi un réchauffement de cache fidèle au comportement réel des utilisateurs et activant les mêmes mécanismes de mise en cache.

Comment le monitoring synthétique réchauffe les caches CDN

L’utilisation du monitoring synthétique pour le réchauffement CDN repose sur plusieurs composants stratégiques :

Stratégie de distribution géographique

Un réchauffement CDN efficace nécessite des agents de monitoring synthétique répartis dans les principales régions géographiques. L’objectif est que chaque emplacement edge important du CDN reçoive régulièrement du trafic synthétique afin de maintenir ses caches chauds. Cela implique généralement :

- Marchés principaux : Les grandes métropoles et zones à fort trafic doivent recevoir des tests synthétiques toutes les 5 à 15 minutes pour maintenir la chaleur des caches.

- Marchés secondaires : Les marchés intermédiaires et les centres régionaux bénéficient d’une surveillance toutes les 15 à 30 minutes, équilibrant fraîcheur du cache et efficacité des ressources.

- Marchés émergents : Même les régions à faible trafic devraient être surveillées toutes les 30 à 60 minutes pour éviter les scénarios de cache froid pour les visiteurs occasionnels.

Priorisation du contenu

Tous les contenus ne nécessitent pas le même niveau de réchauffement. Une approche stratégique classe le contenu par ordre d’importance pour l’entreprise et l’expérience utilisateur :

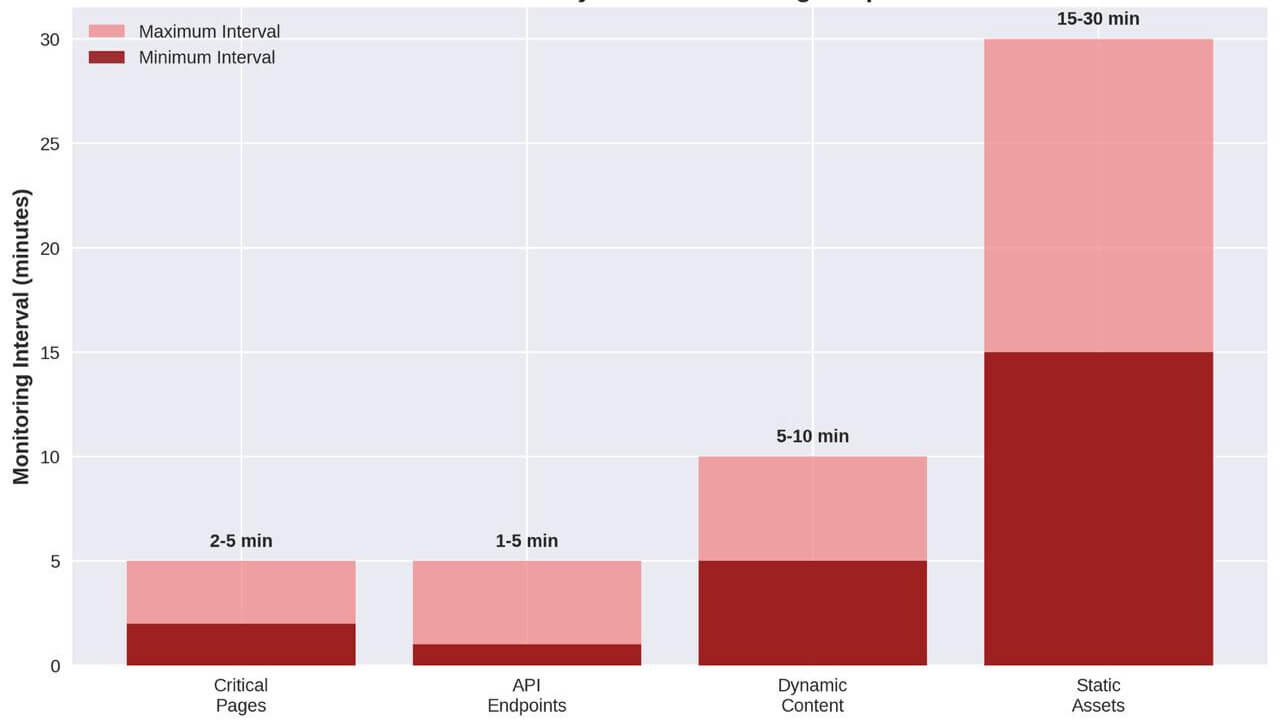

- Ressources critiques : Le contenu de la page d’accueil, les éléments de navigation principaux et les fonctionnalités cœur d’application doivent être surveillés toutes les 2 à 5 minutes.

- Contenu dynamique : Les endpoints API, contenus personnalisés et ressources fréquemment mises à jour bénéficient de tests toutes les 5 à 10 minutes pour un bon équilibre entre fraîcheur et performance.

- Ressources statiques : Les fichiers CSS, JavaScript et images peuvent être réchauffés toutes les 15 à 30 minutes, car leur TTL est souvent plus long et ils changent peu.

- Contenu longue traîne : Les pages et ressources moins critiques peuvent être réchauffées toutes les 30 à 60 minutes pour rester disponibles sans surconsommer les ressources.

Optimisation du timing et de la fréquence

Le timing du monitoring synthétique pour le réchauffement CDN doit tenir compte de plusieurs facteurs :

Fréquences recommandées de monitoring synthétique

Fréquences recommandées de monitoring synthétique- Alignement avec le TTL du contenu : La fréquence des tests doit correspondre à la durée de vie du cache. Par exemple, pour un contenu avec un TTL de 1 h, des tests toutes les 45 minutes assurent que le cache ne se vide jamais.

- Modèles de trafic : La fréquence peut être ajustée selon les périodes de trafic. Les heures de pointe nécessitent un réchauffement plus fréquent, tandis que les heures creuses peuvent être plus espacées.

- Optimisation des ressources : Bien que des tests plus fréquents améliorent la chaleur du cache, ils consomment aussi plus de ressources et génèrent davantage de requêtes vers l’origine. La fréquence optimale équilibre performance et coût.

Dotcom-Monitor : une solution complète

Dotcom-Monitor fournit une plateforme robuste pour mettre en œuvre des stratégies de réchauffement CDN via le monitoring synthétique. La plateforme propose plusieurs fonctionnalités spécifiques utiles pour cette tâche :

Réseau mondial de surveillance

Dotcom-Monitor déploie des agents de monitoring depuis plus de 30 localisations dans le monde, assurant une couverture complète des emplacements edge des CDN. Ce réseau étendu garantit un réchauffement des caches dans toutes les zones géographiques pertinentes.

Tests avec navigateurs réels

La plateforme utilise des navigateurs réels (Chrome, Firefox, Internet Explorer, Safari) pour exécuter les tests, ce qui permet de simuler fidèlement le comportement des utilisateurs et de déclencher les mêmes mécanismes de cache, d’exécution JavaScript et de chargement de ressources.

Options de planification flexibles

Dotcom-Monitor propose des options avancées de planification qui permettent un contrôle précis sur la fréquence des tests. Les intervalles peuvent aller de 1 minute à plusieurs heures, selon les types de contenu ou les régions ciblées.

Métriques de performance détaillées

Au-delà du réchauffement, Dotcom-Monitor fournit des indicateurs de performance utiles pour l’optimisation CDN. Les métriques clés incluent :

- Time to First Byte (TTFB) : Mesure la réactivité des serveurs edge et permet d’identifier les caches froids.

- Temps de chargement complet : Fournit une vision globale de la performance utilisateur et de l’impact du réchauffement.

- Temps par ressource : Détaille la performance par élément, permettant une optimisation ciblée.

- Comparaison géographique : Compare les performances régionales pour identifier les zones nécessitant un renforcement du réchauffement.

Fonctionnalités de scripting avancées

Pour les applications complexes, Dotcom-Monitor permet des scripts avancés simulant des parcours utilisateurs sophistiqués. Cela est utile pour réchauffer le cache de contenus dynamiques nécessitant des interactions ou une authentification.

Mettre en œuvre le monitoring synthétique pour le réchauffement CDN

Une mise en œuvre réussie suit une approche structurée :

Phase 1 : évaluation et planification

Commencez par analyser les performances actuelles du CDN afin d’identifier les caches froids et les disparités géographiques. Cette phase inclut :

- Établir une base de référence : Documenter les valeurs actuelles de TTFB, taux de cache hit et performances régionales.

- Inventaire du contenu : Répertorier les types de contenus, leur importance pour l’expérience utilisateur, et leur configuration de cache.

- Analyse du trafic : Étudier les flux de trafic par région et par heure pour informer la fréquence des tests.

Phase 2 : conception de la stratégie de monitoring

Développez une stratégie globale basée sur les lacunes identifiées :

- Couverture géographique : Mapper les localisations des tests synthétiques aux emplacements edge du CDN.

- Priorisation du contenu : Définir les fréquences en fonction de l’importance du contenu et de son impact métier.

- Optimisation de la planification : Adapter les plannings aux TTL et aux schémas de trafic.

Phase 3 : déploiement et tests

Déployez le monitoring synthétique en validant et en optimisant chaque étape :

- Déploiement progressif : Commencer par les contenus critiques et les régions à fort impact.

- Validation des performances : Suivre en continu l’impact du réchauffement sur les métriques clés.

- Itérations d’optimisation : Ajuster les fréquences et zones couvertes selon les résultats observés.

Phase 4 : optimisation continue

Adaptez et améliorez la stratégie en fonction des évolutions :

- Analyse des tendances : Suivre les performances dans le temps pour détecter de nouvelles opportunités d’optimisation.

- Évolution du contenu : Adapter la stratégie au fur et à mesure de l’ajout ou de la modification des contenus.

- Ajustements saisonniers : Modifier les fréquences en fonction des cycles de trafic ou des événements commerciaux.

La mise en œuvre stratégique du monitoring synthétique pour le réchauffement CDN constitue une base solide pour une performance constante, quel que soit le type de contenu ou la région géographique. Dans la section suivante, nous explorerons les détails techniques et bonnes pratiques pour maximiser l’efficacité de cette approche.

Bonnes pratiques de mise en œuvre

La mise en œuvre d’une stratégie efficace de réchauffement CDN à l’aide du monitoring synthétique nécessite une planification rigoureuse et une exécution soignée. Cette section fournit des recommandations détaillées pour maximiser l’efficacité de vos efforts de mise en cache.

Identifier les contenus critiques à réchauffer

Tous les contenus ne nécessitent pas le même niveau de réchauffement. Une approche stratégique consiste à concentrer les ressources sur les contenus les plus impactants :

Analyse du chemin critique

Commencez par une analyse du chemin critique pour identifier les ressources ayant le plus grand impact sur l’expérience utilisateur :

- Documents HTML principaux : La page d’accueil, les pages produit et les pages d’atterrissage à fort trafic doivent être prioritaires.

- Ressources bloquant le rendu : Les fichiers CSS et JavaScript qui bloquent l’affichage doivent être réchauffés de manière agressive pour réduire le TTI et le FCP.

- Éléments LCP : Les ressources contribuant au Largest Contentful Paint (images principales, contenu above-the-fold) ont un impact direct sur la perception des performances et doivent être prioritaires.

- Endpoints API : Pour les applications dynamiques, les endpoints qui fournissent des données critiques doivent être inclus, surtout s’ils sont mis en cache en edge.

Matrice de catégorisation du contenu

Organisez le contenu par catégories selon leur impact métier et leurs caractéristiques de mise en cache :

| Catégorie de contenu | Impact métier | TTL cache | Fréquence de réchauffement recommandée |

|---|---|---|---|

| Chemin critique | Très élevé | 1–4 heures | Toutes les 2–5 minutes |

| Ressources principales | Élevé | 4–24 heures | Toutes les 5–15 minutes |

| Ressources secondaires | Moyen | 1–7 jours | Toutes les 15–30 minutes |

| Contenu longue traîne | Faible | 7+ jours | Toutes les 30–60 minutes |

Cette catégorisation fournit un cadre pour allouer efficacement les ressources de monitoring tout en assurant une couverture complète.

Optimiser la configuration CDN pour le réchauffement

Un bon réchauffement du cache nécessite des configurations CDN adaptées :

Optimisation des en-têtes Cache-Control

Configurez les en-têtes pour maximiser l’efficacité tout en conservant la fraîcheur :

Cache-Control: public, max-age=3600, s-maxage=86400, stale-while-revalidate=43200

Cette configuration :

- Rend le contenu cacheable publiquement (

public) - Définit le TTL navigateur à 1 h (

max-age=3600) - Définit le TTL CDN à 24 h (

s-maxage=86400) - Autorise la diffusion de contenu expiré pendant 12 h pendant la revalidation (

stale-while-revalidate=43200)

La directive stale-while-revalidate est essentielle, car elle évite les « cache miss » lors de la revalidation.

Personnalisation des clés de cache

Optimisez les clés de cache pour améliorer l’efficacité sans nuire à la cohérence du contenu :

- Exclure les paramètres inutiles : Supprimez les paramètres de tracking des clés de cache.

- Utiliser Vary avec discernement : Évitez les variations inutiles qui fragmentent le cache, mais autorisez celles pertinentes (ex. :

Vary: Accept-Encoding). - Normalisation des URL : Traitez

/produitet/produit/comme identiques.

Logique edge pour contenu dynamique

Activez la mise en cache partielle via la logique edge :

- ESI (Edge Side Includes) : Mettez en cache les modèles de page tout en incluant dynamiquement les composants personnalisés.

- Clés de substitution : Permettent des invalidations ciblées sans tout purger.

- Segmentation de cache : Ciblez les utilisateurs par statut, géographie, etc.

Concevoir des tests de monitoring efficaces

La conception des tests influe directement sur le succès du réchauffement :

Simulation réaliste d’utilisateurs

- Chargement complet : Assurez-vous que tous les assets sont chargés, y compris via JavaScript.

- Interactions utilisateur : Simulez des clics, envois de formulaires, etc., pour déclencher tous les chargements nécessaires.

- Rotation appareils/navigateurs : Réchauffez les variantes spécifiques aux user agents.

Stratégie de distribution géographique

- Marchés prioritaires : Couvrir largement avec plusieurs localisations.

- Mapping edge : Associez les agents aux edge servers pour les cibler directement.

- Pondération par trafic : Plus de tests dans les régions actives, couverture de base ailleurs.

Optimisation de la fréquence de test

- Alignement TTL : Testez juste avant expiration du cache.

- Alignement avec le trafic : Fréquence plus élevée pendant les pics, réduite hors-pic.

- Exécution échelonnée : Répartissez les tests pour éviter des appels simultanés à l’origine.

Gérer les cas spéciaux

Déploiement de contenu / Purge de cache

- Réchauffement en phase : Démarrer par le contenu critique.

- Automatisation purge + réchauffement : Intégrer au pipeline CI/CD.

- Réchauffement canari : Réchauffer quelques régions avant la montée en charge globale.

Contenu authentifié

- Comptes de test dédiés : Avec les permissions nécessaires.

- Rotation sécurisée des tokens : Pour maintenir l’authentification à jour.

- Réchauffement par segment : Couvrez les principales variations utilisateur.

Contenu géo-restreint

- Suites de test régionales : Adaptées au contenu localisé.

- Vérification géo-IP : S’assurer que les agents déclenchent les bonnes versions.

- Conformité légale : Respect des règles de confidentialité locales.

Mesurer et valider l’efficacité du réchauffement

Indicateurs clés de performance

- Taux de cache hit : Cible : >95 % statique, >90 % dynamique

- TTFB par région : Cible : <100 ms pour contenu mis en cache

- Volume des requêtes à l’origine : Doit baisser en proportion du cache hit

- Consistance des performances : Écart-type <10 % entre régions

Méthodes de validation

- Tests A/B : Comparer régions réchauffées vs non réchauffées

- Corrélation synthétique/RUM : Vérifier l’impact réel pour les utilisateurs

- Analyse des headers de cache : Confirmer la présence effective dans le cache

Cas d’étude : optimisation d’une plateforme e-commerce

Une plateforme e-commerce mondiale a mis en œuvre une stratégie de réchauffement via monitoring synthétique, avec des résultats remarquables :

État initial :

- Taux de cache hit : 82 %

- TTFB moyen : 220 ms

- Variation géographique des perfs : 35 %

- Charge serveur origine : élevée, surtout en pics

Mise en œuvre :

- Agents synthétiques déployés dans 24 localisations

- Contenu classé en 4 niveaux avec fréquences adaptées

- CDN optimisé avec stale-while-revalidate

- Réchauffement automatisé après déploiement

Résultats après 30 jours :

- Taux de cache hit : 98,5 % (+16,5 %)

- TTFB moyen : 65 ms (–70 %)

- Variation géographique : 8 % (–77 %)

- Charge origine : –85 %

- Taux de conversion : +4,2 %

Cette étude démontre l’impact transformateur d’une stratégie de réchauffement CDN bien exécutée, tant sur la performance technique que sur les résultats business.

Dans la prochaine section, nous explorerons les techniques avancées pour faire évoluer et optimiser ces stratégies à grande échelle.

Techniques avancées et stratégies de montée en charge

Pour les organisations opérant à grande échelle, les stratégies de réchauffement CDN de base peuvent nécessiter des améliorations via des techniques avancées pour gérer des architectures complexes, d’immenses bibliothèques de contenu et un public mondial. Cette section explore des approches sophistiquées pour faire évoluer et optimiser le réchauffement CDN dans un contexte d’entreprise.

Réchauffement intelligent par apprentissage automatique

Le machine learning peut considérablement améliorer l’efficacité des stratégies de réchauffement en optimisant l’allocation des ressources et en prédisant les besoins en contenu :

Réchauffement prédictif du cache

Mettez en place des modèles prédictifs anticipant les besoins en contenu à partir de données historiques :

- Analyse des schémas de trafic : Utilisez les données historiques pour identifier les tendances et anticiper les contenus à réchauffer en priorité.

- Prédiction de popularité : Analysez les métriques d’engagement pour déterminer les contenus susceptibles d’être sollicités massivement.

- Modélisation saisonnière : Tenez compte des pics saisonniers dans l’intérêt des contenus et ajustez dynamiquement la stratégie de réchauffement.

Optimisation adaptative des fréquences

Déployez des systèmes auto-optimisants ajustant les fréquences selon les performances observées :

- Ajustement basé sur la performance : Augmentez la fréquence pour les ressources ayant un fort taux de cache miss et réduisez-la pour les contenus systématiquement chauds.

- Analyse coût/bénéfice : Équilibrez le coût du monitoring synthétique et les gains de performance pour optimiser le retour sur investissement.

- Adaptation en temps réel : Modifiez les stratégies à la volée selon le trafic actuel, la performance CDN et la charge serveur d’origine.

Intégration dans les pipelines CI/CD

L’intégration fluide dans les workflows de développement garantit que le réchauffement fait partie du cycle de livraison :

Réchauffement post-déploiement automatisé

Automatisez le réchauffement dans le processus de livraison :

- Déclencheurs d’événements : Configurez les pipelines CI/CD pour activer automatiquement les séquences de réchauffement après chaque déploiement.

- Analyse des diffs de contenu : Ciblez le réchauffement uniquement sur les fichiers nouveaux ou modifiés pour économiser les ressources.

- Réchauffement progressif : Commencez par les chemins critiques avant d’élargir au reste du contenu.

Déploiements canari avec réchauffement

Combinez les déploiements canari avec un réchauffement ciblé :

- Coordination par étape : Synchronisez le réchauffement avec les phases de déploiement afin que chaque étape bénéficie d’un cache chaud.

- Seuils de validation : Utilisez les métriques de monitoring comme garde-fous pour arrêter ou annuler les déploiements sous-performants.

- Synchronisation multi-CDN : Appliquez les réchauffements sur tous les fournisseurs pour garantir une performance uniforme.

Optimisation à l’échelle mondiale

Pour les organisations globales, des techniques spécialisées permettent d’optimiser le réchauffement selon les régions :

Cadre de priorisation géographique

Priorisez les régions en fonction de leur valeur stratégique :

- Pondération par valeur marché : Allouez davantage de ressources aux marchés à forte rentabilité.

- Accélération des marchés en croissance : Investissez dans les régions en développement pour accompagner l’expansion.

- Réchauffement événementiel : Renforcez temporairement le réchauffement dans les zones concernées par un événement ou une campagne marketing.

Stratégies multi-CDN

Pour les structures utilisant plusieurs fournisseurs :

- Optimisation par fournisseur : Adaptez les stratégies aux spécificités techniques de chaque CDN.

- Redondance croisée : Réchauffez plusieurs CDNs pour garantir un cache actif malgré une bascule de fournisseur.

- Préparation au routage basé sur la performance : Réchauffez toutes les architectures pour une redirection fluide selon les performances.

Optimisation des ressources à grande échelle

À l’échelle entreprise, l’efficacité devient cruciale :

Stratégies par niveau

Équilibrez couverture et coût via une approche par paliers :

- Saturation du chemin critique : Réchauffement fréquent depuis tous les emplacements pour les ressources vitales.

- Échantillonnage représentatif : Réchauffez une partie des ressources secondaires pour couvrir des ensembles fonctionnels entiers.

- Rotation du contenu longue traîne : Réchauffez périodiquement les contenus moins consultés.

Architecture d’exécution distribuée

Déployez un monitoring distribué pour améliorer l’efficacité :

- Exécution en edge : Agents placés en bordure de réseau pour réduire la latence et simuler les conditions réelles.

- Répartition de la charge : Étalez les tests pour éviter toute surcharge réseau.

- Clusters régionaux : Agents dédiés par région pour cibler les zones proches géographiquement.

Monitoring et analytique avancés

Des outils d’analyse puissants sont essentiels pour piloter la stratégie :

Tableaux de bord complets

Implémentez des interfaces de visualisation globale :

- Cartes thermiques : Affichez les performances par région pour détecter les anomalies.

- Analyse de corrélation : Comparez les activités de réchauffement avec les gains mesurés pour optimiser les efforts.

- Suivi des tendances : Repérez les dérives de performance dans le temps.

Détection d’anomalies et alertes

Automatisez la détection des échecs de réchauffement :

- Reconnaissance de schéma : Utilisez l’IA pour détecter les baisses de performances anormales.

- Alertes prédictives : Anticipez les problèmes avant leur impact réel.

- Remédiation automatique : Déclenchez automatiquement des actions correctives.

Étude de cas : plateforme média mondiale

Une plateforme avec 50 millions d’utilisateurs/jour a mis en œuvre une stratégie avancée :

Défis initiaux :

- Bibliothèque de 500 To mise à jour fréquemment

- Audience mondiale dans 190+ pays

- Multiples CDN aux comportements de cache variés

- Pics saisonniers dépassant 10× le volume de base

Mise en œuvre :

- Modèles IA pour prédire les contenus à réchauffer

- Réchauffement intégré aux déploiements CI/CD

- Stratégie par niveaux avec rotation du contenu longue traîne

- Orchestration du réchauffement sur tous les CDNs

Résultats :

- Taux de cache hit : 99,3 %

- Trafic vers l’origine réduit de 94 % en période de pics

- Variation de performance globale : <5 %

- TTFB <100 ms pour 99,7 % des requêtes

- Coûts d’infrastructure réduits de 32 %

Cette étude illustre comment les techniques avancées permettent aux plus grandes plateformes mondiales d’offrir des performances exceptionnelles tout en maîtrisant leurs ressources.

Perspectives d’avenir du réchauffement CDN

Le domaine du réchauffement CDN continue d’évoluer :

Intégration edge computing

Avec l’essor de l’informatique en périphérie :

- Réchauffement des fonctions edge : Pré-exécuter les fonctions edge pour mettre en cache les traitements.

- Réchauffement de bases edge : Étendre les stratégies aux bases de données en edge.

- Prétraitement intensif : Utiliser la puissance edge pour préparer le contenu côté serveur et réduire la latence.

Optimisation par intelligence artificielle

L’IA jouera un rôle croissant :

- Prédiction du parcours utilisateur : Anticiper les séquences de navigation pour réchauffer les parcours complets.

- Optimisation autonome : Stratégies auto-ajustables sans intervention humaine.

- Coordination multi-plateforme : Harmoniser les réchauffements web, mobile et autres pour une expérience omnicanal homogène.

Ces techniques avancées représentent l’avant-garde du réchauffement CDN, permettant aux entreprises de concilier performance mondiale et maîtrise des coûts.

Conclusion : Transformer les performances CDN grâce au réchauffement proactif

Les réseaux de diffusion de contenu (CDN) ont révolutionné les performances web en rapprochant le contenu des utilisateurs, mais le défi persistant des caches froids reste une limite importante. Comme nous l’avons exploré tout au long de cette analyse technique approfondie, le monitoring synthétique offre une solution puissante à ce problème, permettant aux organisations de transformer leurs CDN de systèmes de cache réactifs en accélérateurs de performance proactifs.

Les avantages de la mise en œuvre d’une stratégie complète de réchauffement CDN vont bien au-delà des simples indicateurs techniques. En éliminant les pénalités liées au cache froid, les organisations peuvent offrir une expérience utilisateur constante et de haute qualité qui influence directement leurs résultats :

- Taux de conversion améliorés : Des performances plus rapides et cohérentes entraînent une augmentation des conversions sur tous les marchés.

- Engagement utilisateur renforcé : La réduction de la latence améliore l’interaction et la consommation de contenu.

- Perception de marque renforcée : Une performance uniforme à l’échelle mondiale crée une image de marque haut de gamme, quel que soit l’emplacement de l’utilisateur.

- Réduction des coûts d’infrastructure : Des taux de cache hit plus élevés réduisent considérablement la charge sur les serveurs d’origine et les coûts associés.

- Résilience opérationnelle accrue : Des caches réchauffés de manière proactive protègent contre les pics de trafic et autres défis opérationnels.

La mise en place du réchauffement CDN via le monitoring synthétique marque une transition d’une optimisation réactive à une optimisation proactive des performances. Plutôt que d’attendre que les utilisateurs subissent et signalent des problèmes, les organisations peuvent garantir une performance optimale avant même l’arrivée des utilisateurs. Cette approche proactive s’aligne parfaitement avec les attentes actuelles en matière d’expérience utilisateur, où même quelques millisecondes de retard peuvent avoir un impact sur la satisfaction et les résultats commerciaux.

À mesure que les applications web deviennent plus complexes et que leur portée mondiale s’élargit, l’importance du réchauffement CDN ne fera que croître. Les organisations qui déploient des stratégies avancées de réchauffement bénéficieront d’un avantage concurrentiel significatif grâce à des performances supérieures, des coûts réduits et une expérience utilisateur améliorée.

Le chemin vers une performance CDN optimale commence par une première étape simple : mettre en place un monitoring synthétique de base pour le contenu critique. À partir de là, les organisations peuvent faire évoluer leur stratégie en intégrant les techniques avancées explorées dans cet article, afin de répondre aux exigences des opérations mondiales les plus complexes.

Adopter le réchauffement CDN via le monitoring synthétique, ce n’est pas seulement optimiser une métrique technique—c’est transformer l’expérience que vous offrez à chaque utilisateur, partout dans le monde.

Références

- Kissmetrics, « How Loading Time Affects Your Bottom Line », https://neilpatel.com/blog/loading-time/

- Cloudflare, « What is Edge Computing? », https://www.cloudflare.com/learning/cdn/glossary/edge-server/

- Web.dev, « Web Vitals », https://web.dev/vitals/

- Akamai, « Cache Hit Ratio: The Key Metric for Happier Users and Lower Expenses », https://www.akamai.com/blog/edge/the-key-metric-for-happier-users

- Kinsta, « WordPress CDN — Improve Load Times By Up To 72% With a CDN », https://kinsta.com/blog/wordpress-cdn/

- Dotcom-Monitor, « Optimize CDNs with Synthetic Monitoring », https://www.dotcom-monitor.com/blog/optimize-cdns-with-synthetic-monitoring/

- Akamai, « Understanding Cache-Control Headers », https://developer.akamai.com/blog/2020/09/25/understanding-cache-control-headers

- Google Developers, « Largest Contentful Paint (LCP) », https://web.dev/lcp/

- MDN Web Docs, « Stale-While-Revalidate », https://developer.mozilla.org/en-US/docs/Web/HTTP/Headers/Cache-Control#stale-while-revalidate

- Fastly, « Edge Side Includes (ESI) Language Specification », https://www.fastly.com/documentation/guides/esi-use